Infrastructure as code

Infrastructure as code

Что такое инфраструктура как код (IaC)?

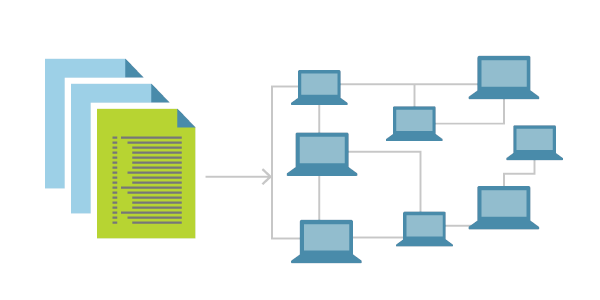

Инфраструктура как код (IaC) использует методологию DevOps и управление версиями с описательной моделью для определения и развертывания инфраструктуры, таких как сети, виртуальные машины, подсистемы балансировки нагрузки и топологии подключений. Так же, как и тот же исходный код всегда создает один и тот же двоичный файл, модель IaC создает одну и ту же среду при каждом развертывании.

IaC — это ключевая практика DevOps и компонент непрерывной поставки. С помощью IaC команды DevOps могут работать вместе с единым набором методик и инструментов для доставки приложений и их вспомогательной инфраструктуры быстро и надежно в большом масштабе.

Избегайте настройки вручную, чтобы обеспечить согласованность

IaC эволюционировал для решения проблемы смещения среды в конвейерах выпуска. Без IaC команды должны поддерживать параметры среды развертывания по отдельности. Со временем каждая среда становится «снежинкой», уникальной конфигурацией, которая не может быть воспроизведена автоматически. Несоответствие сред может вызвать проблемы с развертыванием. Администрирование инфраструктуры и обслуживание связаны с ручным процессом, которые подвержены ошибкам и трудно отслеживать.

IaC избегает ручной настройки и обеспечивает согласованность путем представления требуемых состояний среды с помощью хорошо документированного кода в таких форматах, как JSON. Развертывания инфраструктуры с IaC являются повторяемыми и предотвращают проблемы среды выполнения, вызванные смещением конфигурации или отсутствием зависимостей. Конвейеры выпуска выполняют описания среды и модели конфигурации версий для настройки целевых сред. Чтобы внести изменения, команда изменяет источник, а не целевой объект.

Идемпотентность, способность данной операции всегда производить один и тот же результат, является важным принципом IaC. Команда развертывания всегда устанавливает целевую среду в одну и ту же конфигурацию независимо от начального состояния среды. Идемпотентность достигается путем автоматической настройки существующего целевого объекта или путем отмены существующего целевого объекта и повторного создания новой среды.

Быстро доставить стабильные тестовые среды в большом масштабе

IaC помогает командам DevOps тестировать приложения в рабочих средах в начале цикла разработки. Teams может надежно подготовить несколько тестовых сред по запросу. Облако динамически подготавливает и разрывает среды на основе определений IaC. Сам код инфраструктуры можно проверить и проверить, чтобы предотвратить распространенные проблемы с развертыванием.

Использование декларативных файлов определений

Если это возможно, IaC должен использовать декларативные файлы определения. Файл определения описывает компоненты и конфигурацию, необходимые среде, но не обязательно, как достичь этой конфигурации. Например, файл может определить требуемую версию и конфигурацию сервера, но не указать процесс установки и настройки сервера. Эта абстракция позволяет более гибко использовать оптимизированные методы поставщиков инфраструктуры. Декларативные определения также помогают сократить технический долг по поддержанию императивного кода, например скриптов развертывания, которые могут начисляться с течением времени.

Стандартный синтаксис декларативного IaC отсутствует. Синтаксис описания IaC обычно зависит от требований целевой платформы. Различные платформы поддерживают форматы файлов, такие как YAML, JSON и XML.

Развертывание IaC в Azure

Infrastructure as code: обзор опенсорсных инструментов

Давайте взглянем на текущее положение вещей в индустрии высоких технологий. Все только и говорят, что о DevOps да об облаке, но задачи, связанные с управлением ресурсами сервера и инфраструктуры, определенно пока не входят в разряд легких задач. Если мы выкатываем изменение только на один сервер, это, вероятно, будет не так уж сложно. Но как бы вы справились с заливкой но десятки или сотни серверов? Многие команды по-прежнему практикуют развертывание ресурсов инфраструктуры в облаке вручную, а эта практика зачастую увеличивает вероятность сбоя по мере каждого нового обновления и создает сложные ситуации, из которых нужно восстанавливаться, если что-то пойдет не так.

DevOps может подразумевать несколько разных вещей. DevOps несет культурную трансформацию, которая нацелена то, чтобы каждый инженер чувствовал себя продуктивным и гибким. DevOps также может означать достижение высокой частоты развертываний, при которой сохраняется стабильность. Для обеспечения автоматизации наиболее важной частью DevOps, вероятно, является создание потока ценности (value stream). Чтобы решить эту задачу, многие люди часто рассматривают возможность использования конвейера, такого как Jenkins или GitHub Actions. В то же время в современной экосистеме DevOps наблюдается быстрый рост относительно новой области под названием Infrastructure as Code (инфраструктура как код), так же известной в своей короткой форме — IAC.

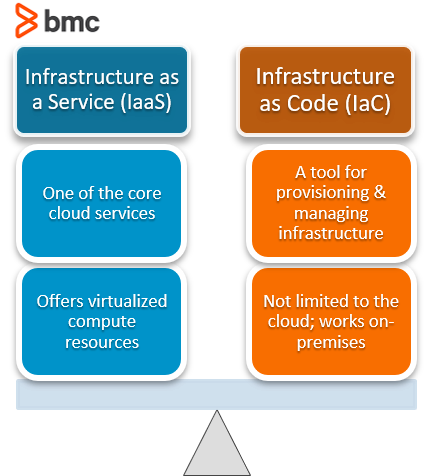

IAC, или Infrastructure as Code, представляет собой процесс подготовки (provisioning) и управления компьютерными центрами обработки данных с помощью машиночитаемых файлов определений, а не физической конфигурации оборудования или интерактивных инструментов конфигурации. Хотя область IAC является относительно новой по сравнению с конвейером автоматизации DevOps, уже существует достаточно много IAC-инструментов, и новые технологии продолжают развиваться даже в этот самый момент. И я рад сообщить вам, что большинство из них — проекты с открытым исходным кодом. В этой статье я хочу представить вам некоторые из наиболее известных и широко используемых IAC-инструментов, распространяемых по опенсорсным лицензиям.

Прежде чем мы углубимся в эту статью, вот несколько терминов, которые могут нам пригодиться.

Agent vs Agentless

(с агентами/без агентов)

IAC-инструмент может требовать запуска агента на каждом сервере, который вы хотите настроить. Если нет, то такой инструмент называется «agentless».

Mutable vs Immutable

Некоторые инструменты, такие как Terraform, занимаются не изменением уже подготовленной (provisioned) инфраструктуры, а развертывают новый сервер, что означает, что они следуют парадигме неизменяемой (immutable) инфраструктуры. Другие инструменты, такие как Ansible, Chef, SaltStack и Puppet, могут изменять существующие ресурсы, а это означает, что эти инструменты следуют парадигме изменяемой (mutable) инфраструктуры.

Procedural vs Declarative

Процедурные языки, такие как Ansible и Chef, позволяют описывать с помощью кода поэтапное выполнение, в то время как декларативные языки, такие как Terraform, SaltStack и Puppet, позволяют просто указать желаемое состояние.

Master vs Masterless

(с мастером/без мастера)

Языки, такие как Chef, требуют, чтобы вы запускали отдельный главный сервер (master), чтобы обеспечить дополнительное управление и постоянные состояния. Другие языки, такие как Ansible и Terraform, не нуждаются в определении мастера.

Configuration vs Provisioning

Ansible, Chef, SaltStack и Puppet известны как инструменты управления конфигурацией, что означает, что их основная цель — настроить ресурсы. Другие инструменты, такие как Terraform и Pulumi, являются инструментами обеспечения (provisioning), а это означает, что их основная цель — предоставлять ресурсы. Однако по мере того, как инструменты развиваются, их функционал может начать пересекаться.

А еще, вот таблица, в которой приведены различные IAC-инструменты с открытым исходным кодом, о которых мы собираемся поговорить, каким лицензиям с открытым исходным кодом они принадлежат и где вы можете найти дополнительную информацию по ним.

Что такое IaC и как Ansible помогает его построить

Зачем появляются такие инструменты, как Ansible? Почему возникают такие направления, как IaC? Ответы на эти вопросы кроются в ряде проблем: большой «зоопарк» серверов, серверы-снежинки, которыми тяжело управлять — как итог, админы постепенно начинают не справляться с ручным управлением.

Infrastructure as Code или инфраструктура как код (IaC) — это подход для управления и описания инфраструктуры через конфигурационные файлы, а не через ручное редактирование конфигураций на серверах. IaC обращается со скриптами / конфигурационными файлами / плейбуками Ansible точно так же, как разработчики обращаются с кодовой базой проекта.

Инфраструктурный код должен проходить коммиты, CI/CD, merge requests, code review. IaC использует высокоуровневый язык описания кода для автоматизации предоставления ИТ-инфраструктуры. Эта автоматизация избавляет разработчиков от необходимости вручную выделять и управлять операционными системами, серверами, подключениями к хранилищам, базам данных и другим элементам инфраструктуры каждый раз, когда нужно написать, протестировать или развернуть программное приложение.

В этом материале разберемся с тем, что такое IaC, какие у него плюсы и минусы, как с ним связан Ansible и какую роль он играет в настройке инфраструктуры. В конце материала немного полезной информации для полного погружения в тему.

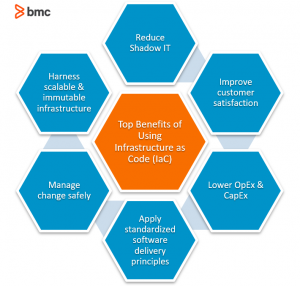

Плюсы IaC

Файлы инфраструктуры хранятся в системе контроля версий. Чтобы приносить пользу, инструменты IaC постоянно совершенствуются. Они помогают предприятиям осуществлять управление инфраструктурами.

Сам подход IaC состоит из декларативного или императивного описания инфраструктуры. Первое более распространено. IaC наиболее популярен в cloud computing и поддерживает IaaS (infrastructure as a service).

Исполнение одного и того же кода в IaC создает одну и ту же исполняемую среду. За счет этого формируется единообразие элементов и их ожидаемое поведение. Идемпотентность помогает проектировать более надежные системы. Операция считается идемпотентной, если ее многократное выполнение приводит к тому же результату, что и однократное выполнение. Взаимодействие с инфраструктурой происходит через конфигурационные файлы, что по большей части исключает присутствие человека.

Безопасность. Помимо прочего, IaC служит определенной формой документации, в которой хранится информация об инфраструктуре, а также выступает некой страховкой на тот случай, когда сотрудники переходят в другие компании. IaC регистрирует, документирует и отслеживает изменения на вашем сервере.

Сокращение затрат. IaC помогает командам работать не только быстро, но и эффективно за счет обеспечения прозрачности. Машинами можно управлять виртуально, что исключает любую ручную настройку оборудования. Один оператор может выполнять развертывание и управление машиной при помощи одного и того же кода. Причем машин может быть сколько угодно. Таким образом, убиваются два зайца: сокращаются затраты за счет отсутствия необходимости закупать новое оборудование и исчезает необходимость дополнительно нанимать новых сотрудников.

Стандартизация. Используя IaC, можно повторять развертывания инфраструктуры, а это предотвращает проблемы, которые обычно вызывает отсутствие зависимостей или, например, дрейф конфигурации. Вероятность появления каких-либо ошибок значительно снижается, ведь IaC всецело стандартизирует сетап инфраструктуры.

Сокращение рисков. IaC может продублировать последнее работоспособное состояние после сбоя, т. к. отслеживает инфраструктуру. Все файлы конфигураций наравне с прочими файлами исходного программного кода попадают под контроль систем управления версиями.

Минусы подхода IaC

У laC есть и минусы, к появлению которых лучше быть готовым заранее. Речь пойдет скорее не о минусах как таковых, а о некоторых ограничениях IaC, о которых инженеры говорят наиболее часто.

Сложность в обслуживании. Да, IaC — это хороший способ отслеживать изменения в инфраструктуре, но когда разработчиков становится больше ста человек, обслуживать IaC, отслеживать и управлять версиями конфигураций становится не так-то просто. Хотя вполне вероятно, что это уже будет не совсем проблема IaC.

Запаздывание фич. Для полного охвата новых облачных фич, которые выпускаются довольно часто и быстро, поставщики инструментов должны обновлять провайдеров. Инструменты IaC не зависят от поставщика и поэтому, в отличие от продуктов, привязанных к поставщикам, они запаздывают с фичами. Может так произойти, что у вас не получится воспользоваться новой фичей, пока вы самостоятельно не введете новые зависимости, не увеличите функциональность или не дождетесь того момента, когда поставщик сам реализует этот функционал.

Необходимость понимать логику скриптов. Что бы вы ни вводили, разработчики должны понимать скрипты IaC. Причем язык их написания абсолютно неважен, и для этого вовсе не нужно разбираться во множестве языков. Без понимания и применения соглашений и логики велик риск столкнуться с проблемами на этапе масштабирования и адаптации.

Ansible как инструмент для построения инфраструктуры

Предположим, что у вас есть тесты, вы умеете собирать приложение, деплоить его. И вроде бы все хорошо. Но представим, что две ваши среды настроены по-разному. Как итог, вы упадете. Мораль здесь довольна проста: среды нужно настраивать одинаково, а конфигурациями критически важно управлять.

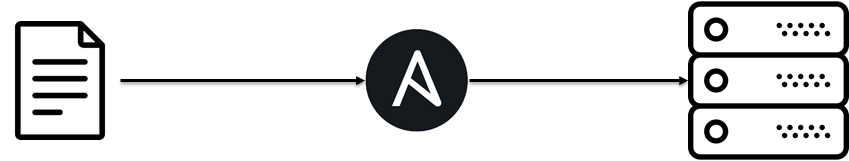

Ansible — одно из средств управления конфигурациями серверов. Он автоматизирует работу с серверами, а также с ПО на них. Вы заранее готовите сценарии, иначе называемые плейбуками. Ansible самостоятельно управляет всеми настройками сети, создает, изменяет или удаляет сервера на облаке, устанавливает или удаляет для них ПО.

Большое преимущество Ansible — это четкое следование философии IaC. С инфраструктурой он работает только через код. Это значит, что на серверах или даже на группах серверов можно поддерживать общее единообразие систем и не сомневаться в корректной работе приложения.

Принцип работы Ansible

Нам наиболее важно то, что Ansible осуществляет четыре правила IaC:

Воспроизводимость всех элементов инфраструктуры.

Возможность избавления от ненужного элемента.

Согласованность данных инфраструктуры.

Отсутствие какого-то «финального» состояния у инфраструктуры.

Если выразить эти правила емко, то получим следующее: инфраструктура меняется, и ее состояние сегодня — это определенный этап. Важно понимать, что завтра произойдут изменения, и Ansible позволяет произвести их наиболее безболезненно.

Есть и другие системы управления конфигурациями серверов: Otter, DSC, SaltStack, Pulumi, Chef, Puppet, CFEngine и, конечно же, Terraform. Ansible и Terraform от всех остальных отличает безагентная модель работы. Проясним: Ansible подключается к серверам и работает на них по SSH.

Открытый порт SSH для Linux и Python 3+, Python 3+, Ansible Windows User и WinRM для Windows — все, что требуется для работы Ansible на удаленном сервере. Сам Ansible устанавливают на компьютер админа, который должен быть на Linux.

Прежде чем в двух предложениях рассказать о принципе работы Ansible, приведем три термина:

нода – это компьютер, где установлен Ansible,

хосты – это удаленные серверы, к которым подключается Ansible,

модули осуществляют все необходимые действия на удаленных серверах.

Теперь будет проще понять концепцию Ansible, которая заключается в следующем: хосты управляются по SSH контрольной нодой с Ansible. Вам не нужны агенты или какое-либо дополнительное ПО на удаленных серверах, если вы работаете на Linux. Для тех, кто предпочитает работать на Windows, есть WSL2.

Теперь об архитектуре. Она тоже достаточно проста и содержит всего четыре элемента.

Modules — скрипты или программы, загружаемые и исполняемые на удаленных серверах.

Inventory — файл, где хранятся данные и где нужно производить необходимые действия.

API — интерфейс взаимодействия с Ansible.

Plugins — расширяющие возможности Ansible сопрограммы.

Ansible довольно простой и эффективный инструмент, позволяющий удаленно управлять конфигурациями. В рамках этого материала мы бегло рассмотрели его основные преимущества. Обстоятельное изучение Ansible позволяет в разы уменьшить объем ручной работы и понять основы автоматической конфигурации.

На курсе «Ansible: Infrastructure as Code» от Слёрма вы разберете реальные кейсы, поймете, как Ansible встраивается в продакшен и как его правильно внедрить в команду. Автор курса – Всеволод Севостьянов, Lead Engineer в Vene. Вместе с Всеволодом вы погрузитесь в 8 тем, изучите 38 уроков, посмотрите 10 часов видеолекций, ознакомитесь с 78 тестовыми и 46 практическими занятиями. Кстати, там еще есть 36 часов стендов для выполнения практик.

5 принципов, о которых нельзя забывать, когда описываешь инфраструктуру в виде кода

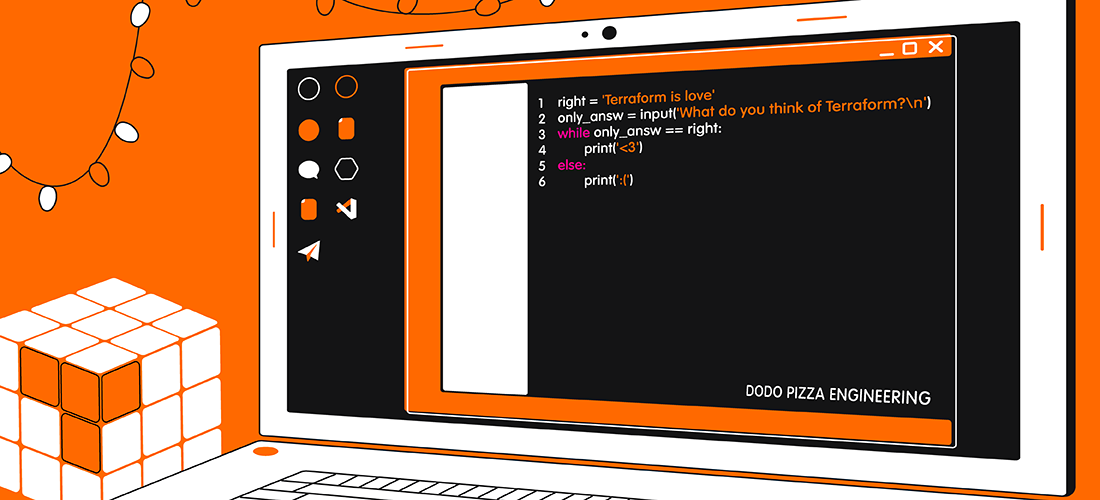

Infrastructure as Code — это подход, который подразумевает описание инфраструктуры в виде коде с его последующим применением для внесения необходимых изменений. Но, как именно писать код, IaC не говорит, только даёт инструменты. Один из таких инструментов — Terraform.

21 мая в Слёрм пройдёт практический интенсив «Terraform Мега». Мы пообщались с его автором Павлом Селиванов, архитектором Yandex.Cloud. Он рассказал, каких принципов нужно придерживаться, когда описываешь инфраструктуру, чтобы на выходе не получить непонятный и плохо поддерживаемый код.

№1. Читаемость

Инфраструктурный код должен быть читаем. Тогда ваши коллеги смогут легко в нём разобраться, а при необходимости — дописать или протестировать. Это вроде элементарная вещь, но о ней часто забывают, и на выходе появляется «write only code» — код, который можно только написать, но нельзя прочитать. Даже его автор спустя пару дней вряд ли сможет понять, что написал, и разобраться, как это всё работает.

Пример хорошей практики — выносить все переменные в отдельный файл. Это удобно, потому что их не приходится искать по всему коду. Вы просто открываете файл и сразу находите то, что нужно.

№2. Стиль написания

Нужно придерживаться определённого стиля написания кода. Например, длина строки кода должна быть в пределах 80-120 символов. Если строки очень длинные, редактор начинает их переносить. Переносы рушат общий вид и мешают пониманию кода. Приходится тратить много времени, чтобы просто разобраться, где началась и где закончилась строка.

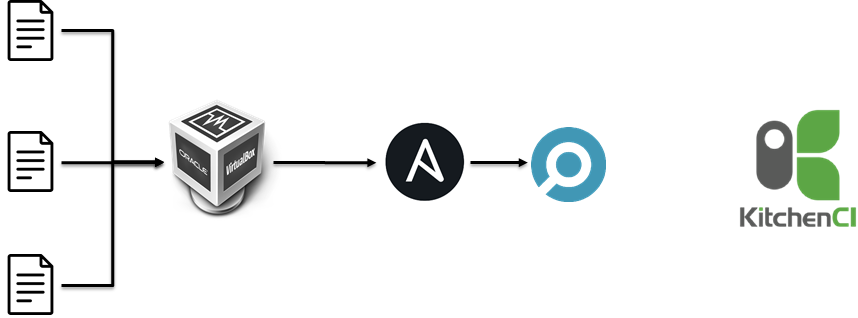

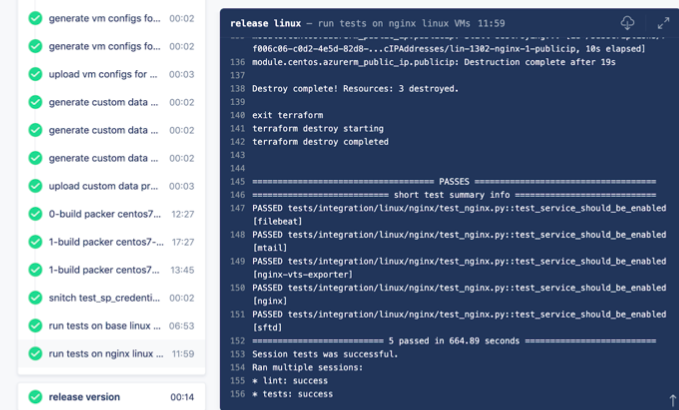

Хорошо, когда проверка написания кода автоматизирована. Для этого можно использовать пайплайн CI/CD. Одним из шагов такого пайплайна должен быть Lint — процесс статистического анализа написанного, который помогает выявить потенциальные проблемы ещё до того, как код будет применен.

№3. Работа с репозиториями

Работайте с репозиториями как разработчик. Важно вести разработку в новых ветках, привязывать ветки к задачам, делать ревью того, что уже было написано, перед внесением изменений отправлять Pull Request и т.д.

С точки зрения специалиста сопровождения перечисленные действия могут показаться лишними — нормальная практика, когда люди просто приходят и начинают коммитить. Если у вас небольшая команда, это ещё может работать. Хотя и в таком случае будет сложно понять, кто, когда, зачем и какие исправления вносил. По мере развития проекта подобные практики будут всё больше усложнять понимание происходящего и мешать работе. Поэтому стоит поучиться тому, как разработка работает с репозиториями.

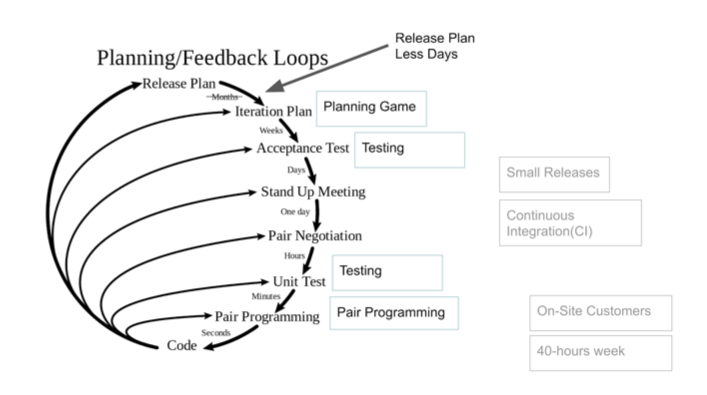

№4. Автоматизация

Инструменты Infrastructure as Code так или иначе ассоциируются с DevOps. А DevOps — специалисты, которые не только занимаются сопровождением, но и помогают разработчикам работать: настраивают пайплайны, автоматизируют запуск тестов и т.д. Всё это тоже относится к IaC.

В Infrastructure as Code должна применяться автоматизация: правила Lint, тестирование, автоматические релизы и др.

Когда у нас есть репозитории с тем же Ansible или Terraform, но выкатываются они вручную — просто приходит инженер и запускает задачу, это не очень хорошо. Во-первых, сложно отследить, кто, зачем и в какой момент её запустил. Во-вторых, нельзя понять, как она работала, и сделать выводы.

Когда всё находится в репозитории и контролируется автоматическим CI/CD-пайплайном, мы всегда можем посмотреть, когда был запущен пайплайн и как он отработал. Можем контролировать параллельное выполнение пайплайнов, выявлять причины сбоев, быстро находить ошибки и многое другое.

№5. Тестирование

Часто от специалистов сопровождения можно слышать, что они никак не тестируют код или просто сначала запускают его где-то на dev. Это не самый удачный вариант тестирования, потому что он не даёт никаких гарантий, что dev соответствует prod. В случае с Ansible или другими инструментами конфигурации стандартное тестирование выглядит примерно так:

запустили тест на dev;

на dev прокатилось, но упало с ошибкой;

исправили эту ошибку;

ещё раз тест не запустили, потому что dev уже находится в том состоянии, к которому его пытались привести.

Кажется, что ошибку поправили, и можно катить на prod. Что случится с prod? Это всегда вопрос везения — попали или не попали, угадали или не угадали. Если где-то на середине, что-то снова упадёт, ошибку поправят и всё перезапустят.

Но инфраструктурный код можно и нужно тестировать. При этом часто даже, если специалисты знают о разных способах тестирования, они все равно не могут ими воспользоваться. Причина — роли Ansible или файлы Terraform написаны без изначального фокуса на то, что их нужно будет как-то тестировать.

Когда разработчик пишет код, он задумывается о том, что его ещё нужно протестировать. И, соответственно, прежде чем начать писать код, планирует, как будет его тестировать. Нетестируемый код — это код низкого качества.

То же относится и к инфраструктурному коду: после написания вы должны суметь протестировать его. Тесты позволяют уменьшить число ошибок и облегчить работу коллег, которые будут дорабатывать ваши роли на Ansible или файлы Terraform.

Пара слов про автоматизацию напоследок

Обычно срабатывает человеческий фактор, и спустя n-ное количество повторов удалять виртуалку и создавать снова становится лень. Кажется, на этот раз всё точно работает как надо, поэтому можно замёржить изменения и прокатить по prod. Но на деле ошибки все равно могут возникать, поэтому и нужна автоматизация. Она работает на автоматических пайплайнах и сигнализирует о новых Pull Request, помогает быстрее выявлять баги и предупреждать их появление.

Все эти принципы применительно к Terraform разберём на интенсиве

21-22 мая Слёрм проведёт практический интенсив «Terraform Мега». За два дня активного участия вы узнаете:

зачем использовать IaC;

как работает Terraform и как с его помощью управлять инфраструктурой;

как писать инфраструктурный код, который будет сопровождаемым и тестируемым;

как лучше использовать Terraform в корпоративном масштабе.

По окончанию интенсива вы будете уверенно разбираться в управлении инфраструктурой как кодом, а ещё сможете работать с Terraform на продвинутом уровне.

Infrastructure as Code: Плюсы, Минусы и Будущее

Infrastructure as Code — ключевой элемент наиболее эффективных инженерных сетапов. То, как сейчас DevOps-инженеры взаимодействуют со своей инфраструктурой — это несомненно большой скачок вперед. Но тем не менее спорные моменты с определением и лучшими практиками IaC до сих пор есть. Эта статья стремится четко описать IaC, его преимущества и важные ограничения.

Infrastructure as Code, или сокращенно IaC, — это фундаментальный сдвиг не только для Ops в том, как они подходят к провизионированию и обслуживанию инфраструктуры, но и в разработке программного обеспечения в целом. Несмотря на то, что за последние несколько лет IaC де-факто зарекомендовал себя как отраслевой стандарт, многие до сих пор спорят о его определении, лучших практиках и ограничениях.

В этой статье вы познакомитесь с эволюцией этого подхода к инфраструктуре рабочих процессов и связанных с ним технологий. Мы объясним, откуда появился IaC, перспективы его развития, его преимущества и его главные ограничения.

От железа к облаку

Еще помните железный век IT, когда вам нужно было покупать собственные серверы и компьютеры? И я уже не помню. Сейчас кажется совершенно безумным, что рост инфраструктуры мог быть ограничен циклом покупки оборудования. Поскольку доставка нового сервера занимала несколько недель, необходимость быстрой установки и настройки на нем операционной системы не стояла так остро. Люди просто вставляли диск в сервер и следовали по пунктам. Через несколько дней он становился доступен для разработчиков. Просто безумие.

С одновременным запуском и повсеместным внедрением AWS EC2 и Ruby on Rails 1.0 в 2006 году многие корпоративные группы столкнулись с проблемами масштабирования, которые ранее возникали только в крупных транснациональных организациях. Облачные вычисления и возможность без усилий запускать новые инстансы виртуальных машин принесли инженерам и предприятиям не только хорошую выгоду, но и дополнительные хлопоты. Теперь им приходилось следить за обслуживаемыми серверами, число которых постоянно росло.

Площадь инфраструктуры средней инженерной организации стала расти по мере того, как небольшое количество больших машин заменялось большим количеством меньших. В какой-то момент стало гораздо больше вещей, которые Ops требовалось провизионировать и поддерживать, и эта инфраструктура имела тенденцию быть циклической. Мы можем масштабироваться, чтобы справиться с пиковой нагрузкой днем, а ночью уменьшать масштаб, чтобы сэкономить на расходах, потому что они не фиксированы. В отличие от необходимости мириться с постоянным устареванием нашего оборудования, мы теперь платим за вычислительные ресурсы почасово. Таким образом, чтобы извлечь максимальную выгоду при использовании облачного сетапа, имеет смысл задействовать только ту инфраструктуру, которая вам необходима.

Чтобы максимально эффективно использовать эту гибкость, нам потребовалась новая парадигма. Создавать тысячу тикетов каждое утро, чтобы набрать максимальную мощность, и еще тысячу тикетов ночью, чтобы снова замедлиться, при этом вручную управлять всем этим, очевидно, становится довольно сложной задачей. Возникает вопрос, как начать операционализировать этот сетап, чтобы он был надежным, устойчивым и исключал ошибки, вызванные человеческим фактором?

Infrastructure as Code

Infrastructure as Code был рожден для решения этих задач максимально систематизированным образом. IaC — это процесс управления и провизионирования датацентров и серверов с помощью машиночитаемых файлов определений, созданный как альтернатива физическому конфигурированию оборудования и оперируемым человеком инструментам. Теперь, вместо того, чтобы запускать сотню различных файлов конфигурации, IaC позволяет нам просто запускать скрипт, который каждое утро поднимает тысячу дополнительных машин, а вечером автоматически сокращает инфраструктуру до приемлемого вечернего масштаба.

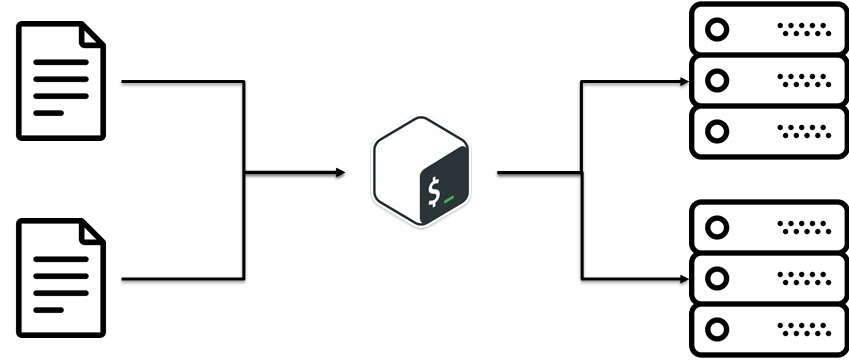

С момента запуска AWS Cloudformation в 2009 году IaC быстро стал неотъемлемой практикой DevOps, незаменимой в жизненном цикле конкурентоспособной доставки программного обеспечения. Он позволяет командам инженеров быстро создавать и версионировать инфраструктуру тем же способом, что и обычный код, и отслеживать эти версии во избежание несогласованности между средами. Обычно команды осуществляют это следующим образом:

Разработчики определяют и пишут инфраструктурные спецификации (infrastructure specs) на специфичном для предметной области языке

Созданные файлы отправляются в API управления, мастер-сервер или репозиторий кода

Затем инструмент IaC, такой как Pulumi, выполняет все действия, которые нужны для создания и настройки необходимых вычислительных ресурсов

И вуаля, ваша инфраструктура внезапно начинает работать на вас, а не наоборот.

Традиционно существует два подхода к IaC, декларативный или императивный, и два возможных метода, push и pull. Декларативный подход описывает конечную цель и определяет требуемое состояние ваших ресурсов. Этот подход отвечает на вопрос о том, что нужно создать, например, «Мне нужны две виртуальные машины». Императивный подход отвечает на вопрос о том, как нужно изменить инфраструктуру для достижения конкретной цели, обычно выдавая последовательность различных команд. Ansible playbooks — отличный пример императивного подхода. Разница между методом push и pull заключается в том, каким образом серверам сообщается информация о конфигурации. В pull режиме каждый сервер будет пулить свою конфигурацию из мастер-сервера, а в push режиме мастер-сервер сам распушивает конфигурацию по целевой системе.

В течение последних десяти лет набор инструментов IaC постоянно эволюционировал, и, вероятно, потребовалась бы целая статья, чтобы дать исчерпывающий обзор всех различных вариантов реализации этого подхода в ее конкретной инфраструктуре. Однако мы составили краткую хронологию основных инструментов, перечисленных по дате релиза:

Infrastructure as Code: первое знакомство

У нас в компании идёт процесс онбординга SRE-команды. Я зашёл во всю эту историю со стороны разработки. В процессе у меня появились мысли и инсайты, которыми я хочу поделиться с другими разработчиками. В этой статье-размышлении я говорю о том, что происходит, как происходит, и как всем дальше с этим жить.

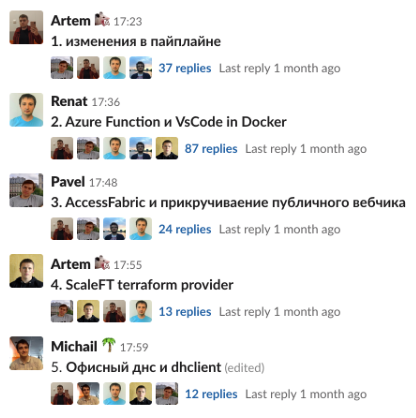

Продолжение серии статей, написанных по мотивам выступлений на нашем внутреннем мероприятии DevForum:

Мы решили сделать команду SRE, воплотив идеи google sre. Набрали программистов из своих же разработчиков и отправили их обучаться на несколько месяцев.

Перед командой стояли следующие учебные задачи:

Вводим понятие Infrastructure as code

В обычной модели мира (классическом администрировании) знания об инфраструктуре находятся в двух местах:

Таким образом инфраструктура как код (Incfastructure as Code – IaC) – это описание всей имеющейся инфраструктуры в виде кода, а также сопутствующие средства по работе с ним и воплощению из него же реальной инфраструктуры.

Итак, мы решили подключить новых SRE-инженеров, но откуда их брать? Книжка с правильными ответами (Google SRE Book) говорит нам: из разработчиков. Ведь они работают с кодом, а вы достигаете идеального состояния.

Мы много и долго искали их на кадровом рынке за пределами нашей компании. Но вынуждены признать, что не нашли ни одного под наши запросы. Пришлось пошерстить среди своих.

Проблемы Infrastructure as code

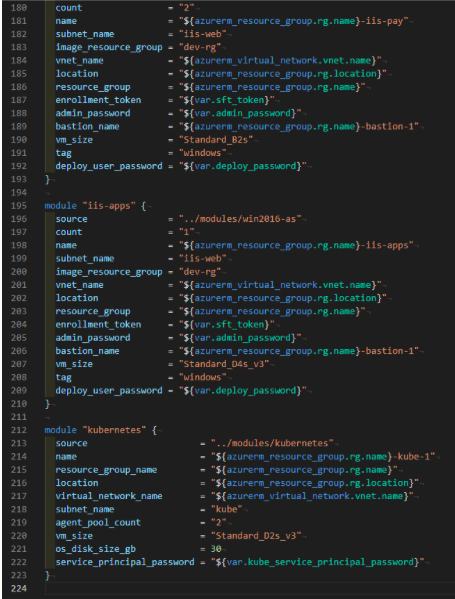

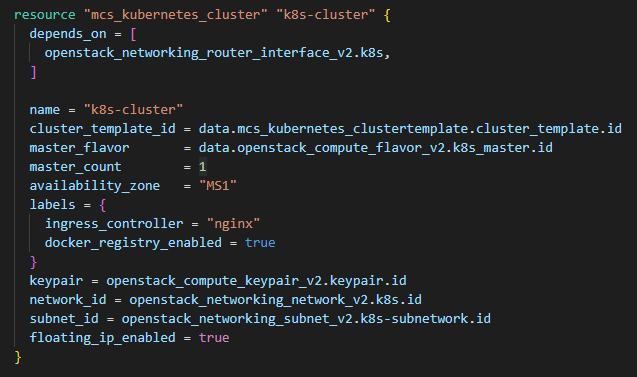

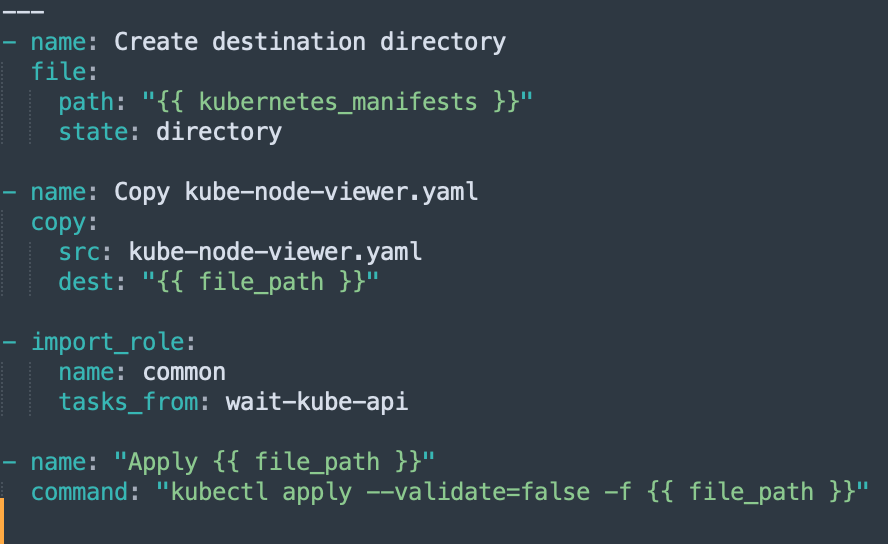

Теперь давайте посмотрим примеры того, как инфраструктура может быть зашита в код. Код хорошо написан, качественно, с комментами и отступами.

Пример кода из Terraforma.

Пример кода из Ansible.

Господа, но если бы всё было так просто! Мы же с вами в реальном мире, а он всегда готов удивить вас, преподнести сюрпризы, проблемы. Не обходится без них и здесь.

1. Первая проблема состоит в том, что в большинстве случаев IaC – это какой-то dsl.

А DSL, в свою очередь, – это описание структуры. Точнее того, что у тебя должно быть: Json, Yaml, модификации от каких-то крупных компаний, которые придумали свой dsl (в терраформе используется HCL).

Беда в том, что в нём может легко не быть таких привычных нам вещей как:

Вполне реальная ситуация, когда баш с питоном запускает какой-то процесс, в который подсовывается Json. Вы его анализируете, потом еще какой-то генератор выдает ещё 30 файлов. Для всего этого поступают входные переменные из Azure Key Vault, которые стянуты плагином к drone.io, написанным на Go, и переменные эти проходят через yaml, который получился в результате генерации из шаблонизатора jsonnet. Довольно сложно иметь строго хорошо описанный код, когда у вас настолько разнообразная среда.

Традиционная разработка в рамках одной задачи идет с одним языком. Здесь же мы работаем с большим количеством языков.

3. Третья проблема – это тулинг. Мы привыкли к крутым редакторам (Ms Visual Studio, Jetbrains Rider), которые все делают за нас. И даже, если мы затупили, они скажут, что мы не правы. Кажется, что это нормально и естественно.

Но где-то рядышком есть VSCode, в котором есть какие-то плагины, которые как-то ставятся, поддерживаются или не поддерживаются. Вышли новые версии, и их не поддержали. Банальный переход к имплементации функции (даже если она есть) становится сложной и нетривиальной проблемой. Простой ренейм переменной – это реплейс в проекте из десятка файлов. Повезёт, если он то, что надо зареплейсит. Есть, конечно, кое-где подсветка, есть автокомплишн, где-то есть форматинг (правда у меня в терраформе на винде не завелся).

На момент написания статьи vscode-terraform plugin еще не выпустили для поддержки версии 0.12, хотя она зарелижена уже как 3 месяца.

Пришло время забыть о.

Самое страшное, что мы вынуждены думать не о том как спроектировать, разложить файлики по папочкам, декомпозировать, сделать поддерживаемым, читаемым и так далее код, а о том, как бы мне корректно написать эту команду, потому что я её как-то неправильно написал.

Как новичок вы пытаетесь познать терраформ, а IDE вам в этом нисколько не помогает. Когда есть документация – зашли, посмотрели. Но если бы вы въезжали в новый язык программирования, то IDE подсказала бы, что есть такой тип, а такого нет. По крайней мере, на уровне int или string. Это часто бывает полезным.

А как же тесты?

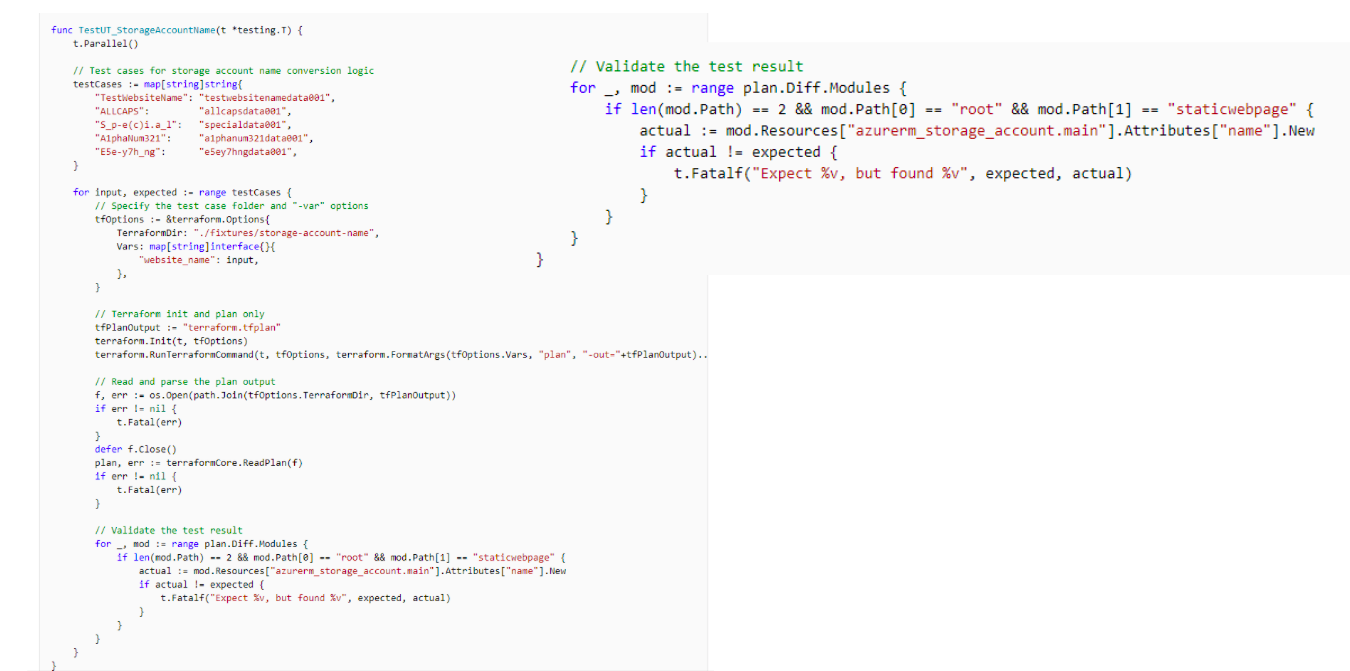

Вы спросите: «Как же тесты, господа программисты?» Серьёзные ребята тестируют всё на проде, и это жестко. Вот пример юнитеста для терраформ-модуля с сайта Microsoft.

У них хорошая документация. Microsoft мне всегда нравились своим подходом к документации и обучению. Но не нужно быть дядюшкой Бобом, чтобы понять, что здесь не идеальный код. Обратите внимание на валидацию, вынесенную вправо.

Проблема unit-теста в том, что мы с вами можем проверить корректность Jsonа на выходе. Я кинул 5 параметров, мне выдалась портянка Json на 2000 строк. Я могу проанализировать, что здесь происходит, validate test result…

Сложно анализировать Json в Go. А надо писать в Go, потому что терраформ на Go – это хорошая практика того, что тестируешь в том языке, в котором ты пишешь. Сама организация кода очень слабая. При этом – это лучшая библиотека для тестирования.

Сам Microsoft пишет свои модули, тестируя их таким способом. Конечно, это Open Source. Всё, о чем я говорю вы можете прийти и починить. Я могу сесть и за недельку всё починить, заопенсорсить плагины VS-кода, терраформ, сделать плагин для райдера. Может быть, написать парочку анализаторов, прикрутить линтеры, законтрибьютить библиотеку для тестирования. Всё могу сделать. Но я не этим должен заниматься.

Лучшие практики Infrastructure as code

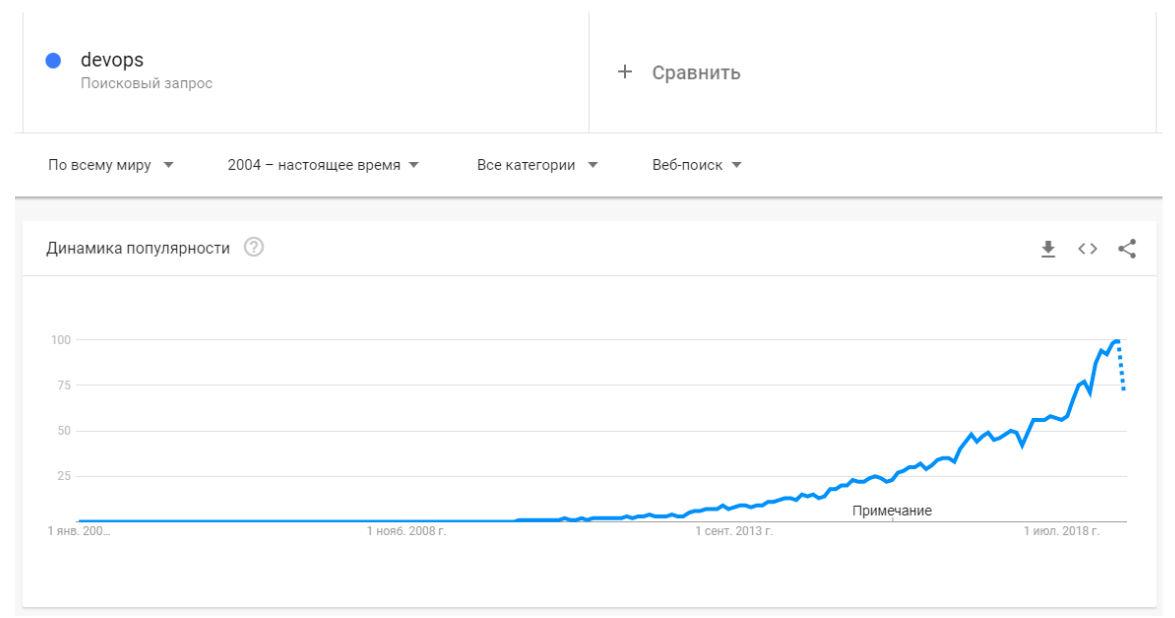

Едем дальше. Если в IaC нет тестов, плохо с IDE и тулингом, то должны быть хотя бы лучшие практики. Я просто пошёл в гугл-аналитику и провёл сравнение двух поисковых запросов: Terraform best practices и c# best practices.

Что мы видим? Беспощадную статистику не в нашу пользу. По количеству материала – то же самое. В C# разработке мы просто купаемся в материалах, у нас есть сверхлучшие практики, есть книги написанные экспертами, и также книжки, написанные на книжки другими экспертами, которые критикуют те книжки. Море официальной документации, статей, обучающих курсов, сейчас еще и open source разработка.

Что касается запроса по IaC: здесь вы по крупицам пытаетесь собрать инфу с докладов хайлоада или HashiConf, с официальной документации и многочисленных issue на гитхабе. Как вообще эти модули раскидывать, что с ними делать? Кажется, что это реальная проблема… Есть же комьюнити, господа, где на любой вопрос тебе дадут 10 комментов на гитхабе. Но это не точно.

К сожалению, в данный момент времени эксперты только начинают появляться. Пока их слишком мало. А само комьюнити болтается на уровне зачатков.

Куда всё это движется и что делать

Можно всё бросить и пойти обратно на C#, в мир райдера. Но нет. Зачем вы вообще стали бы этим заниматься, если не найти решение. Далее я привожу свои субъективные выводы. Можете поспорить со мной в комментариях, будет интересно.

Лично я ставлю на несколько вещей:

Может быть тема хайповая, но сам факт того, что сфера растёт, вселяет некоторую надежду.

Банальный пример: совместная работа через pair programming. Он сильно помогает разобраться. Когда у тебя есть рядом сосед, который тоже что-то пытается понять, вместе вы поймёте лучше.

Понимание о том, как делается рефакторинг помогает даже в такой ситуации производить его. То есть, ты можешь поменять не всё сразу, а поменять нейминг, потом поменять расположение, потом может выделить какую-то часть, ой, а здесь не хватает комментариев.

Заключение

Следом идёт вторая часть статьи. В ней я рассказываю о том, как мы применяли практики экстремального программирования, чтобы улучшить наш процесс обучения и работу с инфраструктурой.

Много машин в облаке — это не больно: IaC для управления масштабной инфраструктурой

Server Room by OliverWeiss97

Здравствуй, Хабр! Меня зовут Алексей Волков, я продуктовый менеджер Kubernetes как сервис в VK Cloud Solutions. Исторически сложилось так, что настройка серверов — это ручной труд. Однако по мере роста и усложнения инфраструктуры управлять ею все сложнее.

В этой статье я расскажу, что такое инфраструктура как код, дам общее представление о принципах, на которых строится IaC, и постараюсь показать, как правильные подходы позволяют без проблем управлять огромным парком виртуальных машин.

Что такое Infrastructure-as-Code

Системным администраторам приходится иметь дело с десятками, а то и сотнями одинаковых или очень похожих серверов. Если создавать и обслуживать машины вручную, появляются расхождения в настройках, а с ними — неудобства и ошибки.

Представьте два прокси-сервера Nginx, через которые постоянно проходят запросы клиентов. Администратор вручную меняет настройки на одном сервере, затем на другом. Уходит на перерыв, а по возвращении забывает о первом и перезагружает только второй сервер. В итоге половина клиентов видит одну информацию, а половина — другую.

Это сравнительно безобидный пример. Иногда расхождения в настройках машин вызывают баги, которые отлавливают месяцами. Однако еще с 2009 года существует альтернативный подход: AWS Cloudformation предложила автоматизировать управление инфраструктурой при помощи Infrastructure as Code (IaC). Это описание конфигурации инфраструктуры в виде программного кода. Он обрабатывается специализированными инструментами, которые самостоятельно приводят инфраструктуру в нужное состояние.

Альтернативный IaC-подход имеет целый ряд преимуществ:

Подходы к описанию развертывания

Чтобы IaC заработал, необходимо описать будущую инфраструктуру, интерпретировать код и распространить настройки. Это можно делать двумя способами.

Инструменты для развертывания и управления IаC

За автоматизацию развертывания инфраструктуры в IaC отвечает специализированное инфраструктурное ПО. Есть две наиболее популярные утилиты:

Terraform — один из самых распространенных инструментов на основе декларативного подхода. Это система управления конфигурациями с открытым исходным кодом, предназначенная для высокоуровневого описания облачной и локальной инфраструктуры. По сути, это оркестратор — средство удобного создания инфраструктуры.

Так выглядит работа в Terraform

Ansible. Это, скорее, configuration management system — программа для управления готовой инфраструктурой, установки пакетов и изменения конфигураций. Она использует императивный подход.

Так выглядит работа в Ansible

Для описания конфигурации инфраструктуры используются специальные языки программирования. Ansible, как и многие другие инструменты IaC, использует YAML. Для Terraform HashiCorp разработала собственный язык — HCA. Это не полнофункциональные (полные, по Тьюрингу) языки, а, скорее, узкоспециализированные наборы инструкций, так что они проще в освоении.

Методы распространения изменений по инфраструктуре

IaC нужен в том числе для того, чтобы гибко изменять инфраструктуру. Существует два подхода к внесению изменений:

Terraform работает по Push-модели, Ansible поддерживает обе. Другие инструменты — Puppet, Chef или SaltStack — по большей части используют Pull-модель. Такое разнообразие нужно потому, что нельзя однозначно сказать, какой подход лучше. Выбор зависит от задач, предпочтений и навыков работы с конкретными инструментами.

IaC и VK Cloud Solutions

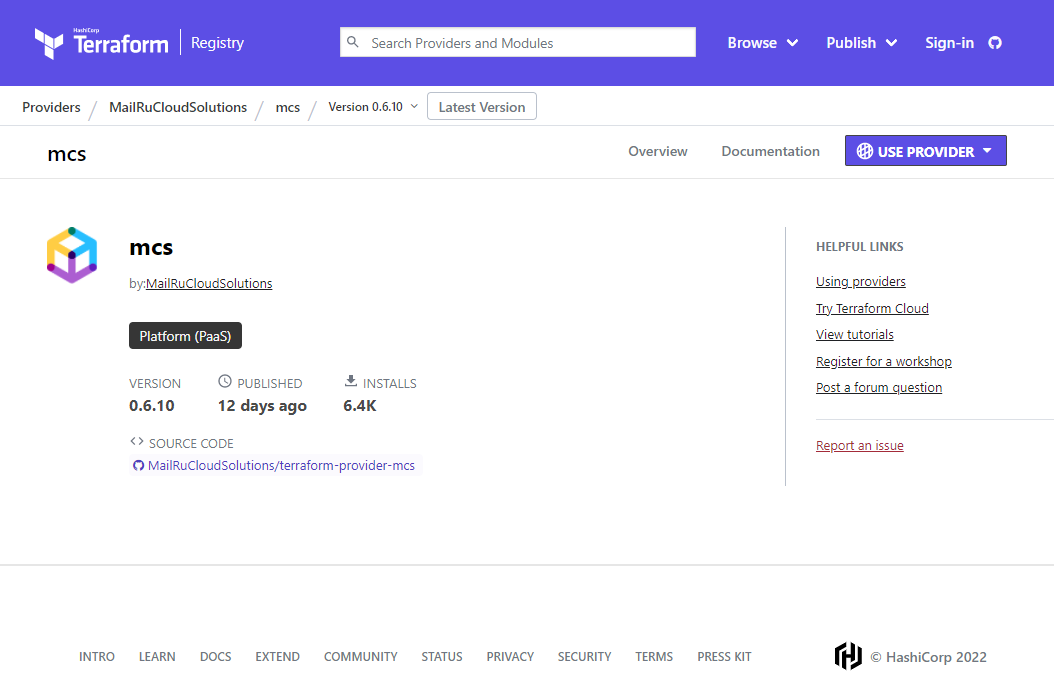

Облачные провайдеры, как правило, работают с одной или несколькими системами управления конфигурациями. Платформа VK Cloud Solutions построена на OpenStack, так что с нашим облаком можно использовать любой инструмент, который работает с OpenStack API. Однако мы сосредоточились на поддержке Terraform как одного из самых популярных и удобных инструментов.

Наш Terraform-провайдер в Terraform Registry

У нас есть собственный Terraform-провайдер, предназначенный для работы с нашей PaaS-инфраструктурой, то есть с базами данных и Managed Kubernetes. Написана подробная документация по API.

Мы развиваем IaC, потому что он снижает количество ошибок со стороны клиента и, соответственно, нагрузку на техническую поддержку. Не говоря уже о том, что просто интересно развивать современные подходы к управлению инфраструктурой.

Конечно, мы по-прежнему развиваем и графический интерфейс, через который можно управлять инфраструктурой вручную, и окончательный выбор в пользу того или иного способа управления остается за клиентом.

Как переехать на IaC

Начать использовать IaC в новом проекте достаточно просто. Другое дело, если необходимо провернуть этот трюк на уже работающей инфраструктуре.

Подготовка к переезду. Убедитесь, что в команде есть человек, который умеет пользоваться, например, Terraform. Дайте ему время, чтобы освежить знания. И имейте в виду, что во время перехода на IaC потребление ресурсов и стоимость поддержания инфраструктуры могут возрасти. Вероятно, в процессе переезда придется поддерживать дополнительные копии тех или иных сервисов.

На мой взгляд, не стоит трогать текущую инфраструктуру. Лучше использовать принципы Infrastructure-as-Code, чтобы выстроить параллельную и переезжать на нее постепенно.

Пошаговый переход. Для начала можно взять серверы, которые отвечают за балансировку трафика, развернуть аналогичные при помощи IaC и подключить к системе CI/CD. Все автоматизировать, настроить, протестировать. И только после этого переключить трафик и отключить старые серверы. Затем выбрать другую группу серверов и повторить процесс.

Такой пошаговый подход несколько замедляет переезд, но зато спасает от серьезных ошибок и переделок. Если постепенно запускать на основе IaC отдельные узлы или точки инфраструктуры, гораздо проще понять, куда двигаться и как сделать систему удобнее.

В противном случае можно потратить уйму времени на описание всей инфраструктуры, переехать на IaC и в одночасье понять, что новый подход не решает бизнес-задачи. Или что конфигурационные файлы плохо написаны, неудобны, не работают, как ожидалось. Ведь в конечном счете чем аккуратнее и лучше написан код, тем проще управлять инфраструктурой.

Внедрение Best Practices. В IaC актуальны все те же принципы и Best Practices, что и в разработке ПО. Например, люди, которые пишут на Ansible, часто признаются, что не тестируют свою инфраструктуру. Они говорят, что их задачи невозможно протестировать, но с точки зрения разработки это признак плохого кода.

В таких случаях опытный разработчик выбирает такую реализацию, которая поддается тестированию, даже если этот способ не так прост и удобен лично для него. Синтаксис кода в IaC можно проверять при помощи статических анализаторов (линтеров) и автоматизированных инструментов.

В системное администрирование стоит перенести и другие принципы разработки. Например, важно заботиться о читаемости инфраструктурного кода. Его стоит снабжать комментариями, разбивать на модули и выносить в переменные всё, что должно меняться.

Модули (Terraform), таски, плейбуки и роли (Ansible) позволяют переиспользовать готовый проверенный код во многих местах. Это повышает читаемость кода и снижает вероятность ошибки.

Очень полезен и опыт работы с репозиториями, Git, ветками, Review, пайплайнами, автоматизацией, CI/CD — всем этим можно и нужно пользоваться при написании инфраструктурного кода. В противном случае со временем конфигурационные файлы превращаются в нечитаемое полотно, в которое очень сложно вносить изменения. Так теряется большинство их преимуществ.

Сложности и подводные камни IaC

Существует и обратная сторона монеты. Управлению архитектурой мешает не только небрежность в написании кода, но и перфекционизм, свойственный опытным специалистам. Порой они увлекаются идеальной архитектурой, и код получается не совсем такой, какой нужен бизнесу.

Кроме того, важно учитывать, что к работе над инфраструктурой необходимо привлекать специалистов по информационной безопасности. Иначе IaC приведет к одной из двух ситуаций:

Важно учитывать еще один момент: названия сущностей в API облачных провайдеров различаются. Поэтому при переезде из одного облака в другое конфигурационные файлы, возможно, придется редактировать. Впрочем, наша служба поддержки часто помогает клиентам с переездом, и проблем с этим не возникает.

Ошибки встречаются редко и связаны не с Infrastructure-as-Code как с подходом, а с особенностями работы облачной инфраструктуры.

Один из наших клиентов хотел описать конфигурацию в Terraform таким образом, чтобы на мастеры устанавливать инверс-контроллеры. Ему требовалось добавить API-серверы мастеров в наш облачный балансировщик. Тогда обнаружилось, что при конфигурации кластеров Kubernetes наш провайдер неверно отдает список IP-адресов мастер-ноде кластера. Клиент написал в техподдержку, и мы все исправили. Такие баги фиксятся в течение нескольких часов.

Будущее IaC

Нельзя сказать, что Infrastructure-as-Code остро необходим компаниям с небольшой несложной инфраструктурой, особенно, если в штате нет системных администраторов с нужными знаниями.

Если вам нужно раз в несколько лет добавлять к инфраструктуре еще один сервер, то это можно сделать руками за день или два. А на то, чтобы с нуля разобраться в инструментах и написать хороший конфигурационный файл, потребуется около месяца. В этом случае IaC не нужен.

Однако ситуация меняется, как только речь заходит о более сложных задачах. Когда серверов много, Infrastructure-as-Code обеспечивает детальный контроль над инфраструктурой и значительно экономит время на всех операциях с ней.

Кодовая база IaC постепенно развивается и все больше походит на полноценный язык программирования с многочисленными абстракциями. Инструменты вроде Terraform становятся умнее и удобнее.

Судя по всему, время ручных действий в больших ИТ-проектах уже прошло, просто еще не все это осознали.

Что почитать по теме

Если после этой статьи вы захотели попробовать IaC, прежде всего стоит заглянуть на сайт Terraform. Там опубликованы не только техническая документация, но и многочисленные статьи с инструкциями. Еще можно изучить документацию облака, в котором вы будете разворачивать инфраструктуру. Например, такая документация есть у VK Cloud Solutions.

На нашей платформе VK Cloud Solutions можно протестировать Terraform. Для этого при регистрации мы начисляем пользователям 3000 бонусных рублей — приходите, пробуйте и оставляйте обратную связь.

Что я узнал, протестировав 200 000 строк инфраструктурного кода

Подход IaC (Infrastructure as Code) состоит не только из кода, который хранится в репозитории, но еще людей и процессов, которые этот код окружают. Можно ли переиспользовать подходы из разработки ПО в управление и описание инфраструктуры? Будет не лишним держать в голове эту идею, пока будете читать статью.

Infrastructure as bash history

Предположим приходите вы на новый проект, а вам говорят: «у нас Infrastructure as Code«. В реальности оказывается, Infrastructure as bash history или например Documentation as bash history. Это вполне реальная ситуация, например, подобный случай описывал Денис Лысенко в выступление Как заменить всю инфраструктуру и начать спать спокойно, он рассказал как из bash history они получили стройную инфраструктуру на проекте.

При некотором желании, можно сказать, что Infrastructure as bash history это как код:

Infrastructure as Code

Даже такой странный случай как Infrastructure as bash history можно притянуть за уши к Infrastructure as Code, но когда мы захотим сделать что-нибудь посложнее чем старый добрый LAMPовый сервер, мы прийдем к тому, что этот код необходимо как-то модифицировать, изменять, дорабатывать. Далее хотелось мы будем рассматривать параллели между Infrastructure as Code и разработкой ПО.

На проекте по разработке СХД, была подзадача периодически настраивать SDS: выпускаем новый релиз — его необходимо раскатать, для дальнейшего тестирования. Задача предельно простая:

Для описанной логики более чем достаточно bash, особенно на ранних стадиях проекта, когда он только стартует. Это не плохо что вы используете bash, но со временем появляются запросы развернуть нечто похожее, но чуть-чуть отличающиеся. Первое что приходит в голову: copy-paste. И вот у нас уже два очень похожих скрипта, которые делают почти тоже самое. Со временем кол-во скриптов выросло, и мы столкнулись с тем, что есть некая бизнес логика развертывания инсталляции, которую необходимо синхронизировать между разными скриптами, это достаточно сложно.

Оказывается, есть такая практика D.R.Y. (Do not Repeat Yourself). Идея в том, чтобы переиспользовать существующий код. Звучит просто, но пришли к этому не сразу. В нашем случае это была банальная идея: отделить конфиги от скриптов. Т.е. бизнес логика как разворачивается инсталляция отдельно, конфиги отдельно.

S.O.L.I.D. for CFM

Со временем проект рос и естественным продолжением стало появление Ansible. Основная причина появления его это наличие экспертизы в команде и что bash не предназначен для сложной логики. Ansible тоже стал содержать сложную логику. Для того что бы сложная логика не превращалась в хаос, в разработке ПО существуют принципы организации кода S.O.L.I.D. Так же, например, Григория Петров в докладе «Зачем айтишнику личный бренд» затронул вопрос, что человек, так устроен, что ему проще оперировать какими-то социальными сущностями, в разработке ПО это объекты. Если объединить эти две идеи продолжить развивать их, то можно заметить, что в описании инфраструктуры тоже можно использовать S.O.L.I.D. что бы в дальнейшем было проще поддерживать и модифицировать эту логику.

The Single Responsibility Principle

Каждый класс выполняет лишь одну задачу.

Не надо смешивать код и делать монолитные божественные макаронные монстры. Инфраструктура должна состоять из простых кирпичиков. Оказывается, что если раздробить Ansible playbook на небольшие кусочки, читай Ansible роли, то их проще поддерживать.

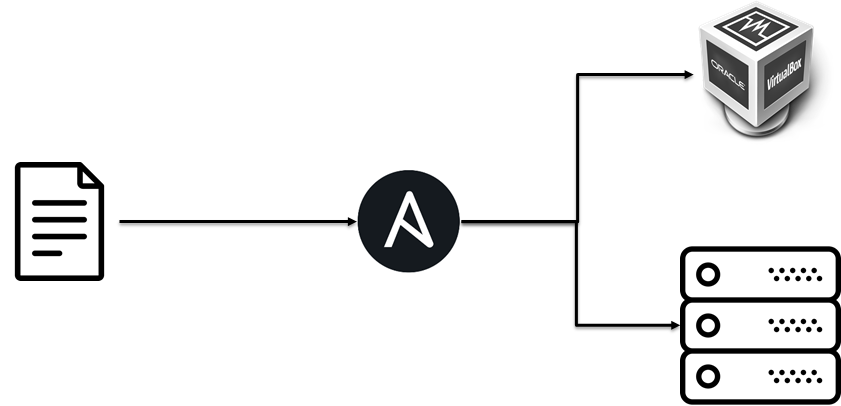

The Open Closed Principle

Изначально мы разворачивали тестовую инфраструктуру на виртуальных машинах, но за счет того, что бизнес логика разворачивания была отдельно от реализации, мы без проблем добавили раскатку на bare-metall.

The Liskov Substitution Principle

Принцип подстановки Барбары Лисков. объекты в программе должны быть заменяемыми на экземпляры их подтипов без изменения правильности выполнения программы

Если посмотреть шире, то не особенность какого-то конкретного проекта, что там можно применить S.O.L.I.D., оно в целом про CFM, например, на другом проекте необходимо разворачивать коробочное Java приложение поверх различных Java, серверов приложений, баз данных, OS, итд. На это примере я буду рассматривать дальнейшие принципы S.O.L.I.D.

В нашем случае в рамках инфраструктурной команды есть договоренность, что если мы установили роль imbjava или oraclejava, то у нас есть бинарный исполняемый файл java. Это нужно т.к. вышестоящее роли зависят от этого поведения, они ожидают наличие java. В тоже время это нам позволяет заменять одну реализацию/версию java на другую при этом не изменяя логику развертывания приложения.

Проблема здесь кроется в том, что в Ansible нельзя реализовать такое, как следствие в рамках команды появляются какие-то договоренности.

The Interface Segregation Principle

Принцип разделения интерфейса «много интерфейсов, специально предназначенных для клиентов, лучше, чем один интерфейс общего назначения.

Изначально мы пробовали складывать всю вариативность разворачивания приложения в один Ansible playbook, но это было сложно поддерживать, а подход, когда у нас специфицирован интерфейс наружу (клиент ожидает 443 порт) то под конкретную реализацию можно компоновать инфраструктуру из отдельных кирпичиков.

The Dependency Inversion Principle

Принцип инверсии зависимостей. Модули верхних уровней не должны зависеть от модулей нижних уровней. Оба типа модулей должны зависеть от абстракций. Абстракции не должны зависеть от деталей. Детали должны зависеть от абстракций.

Здесь пример будет основан на антипаттерне.

Т.е. высокоуровневая логика развертывания приложения, зависимостями протекала на нижележащие уровни гипервизора, и это означало проблемы при переиспользование этой логики. Не надо так.

Interaction

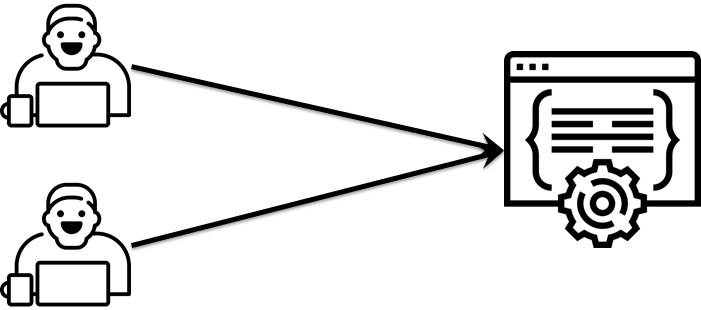

Инфраструктура как код — это не только про код, но ещё и про отношения между кодом и человеком, про взаимодействия между разработчиками инфраструктуры.

Bus factor

Предположим, что у вас на проекте есть Вася. Вася всё знает про вашу инфраструктуру, что будет если Вася вдруг пропадет? Это вполне реальная ситуация, ведь его может сбить автобус. Иногда такое случается. Если такое случится и знание о коде, его структуре, как он работает, явках и паролях, не распределены в команде, то можно столкнуться с рядом неприятных ситуаций. Что бы минимизировать эти риски и распределить знание в рамках команды можно использовать различные подходы

Pair Devopsing

Это не как в шутке, что админы пили пиво, пароли меняли, а аналог парного программирования. Т.е. два инженера садятся за один компьютер, одну клавиатуру и начинают вместе настраивать вашу инфраструктуру: сервер настраивать, Ansible роль писать, итд. Звучит красиво, но у нас не сработало. Но вот частные случаи этой практики работали. Пришел новый сотрудник, его наставник вместе с ним берет реальную задачу, работает — передает знание.

Другой частный случай, это incident call. Во время проблемы собирается группа дежурных и причастных, назначается один ведущий, который расшаривает свой экран и озвучивает ход мысли. Другие участники следуют за мыслью ведущего, подсматривают трюки из консоли, проверяют что не пропустил строчку в логе, узнают новое об системе. Такой подход скорее работал, чем нет.

Code Review

Субьективно, более эффективно распространение знаний об инфраструктуре и том как она устроена проходило при помощи code review:

Изюминкой здесь было, то что ревьюверы выбирались по очереди, по графику, т.е. с некоторой долей вероятности ты залезешь в новый участок инфраструктуры.

Code Style

Со временем стали появляться склоки во время ревью, т.к. у ревьюверов был свой стиль и ротируемости ревьюверов стакивала их с разными стилями: 2 пробела или 4, camelCase или snake_case. Внедрить это получилось не сразу.

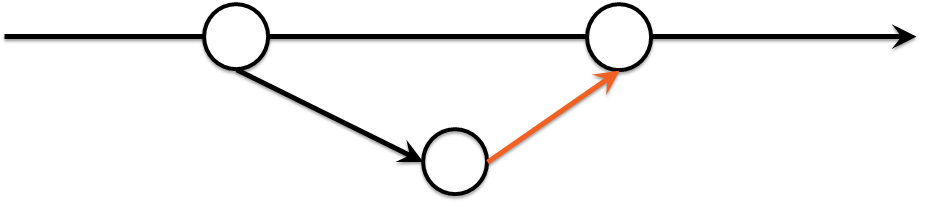

Green Build Master

Время идет, и пришли к тому что нельзя пускать в мастер коммиты, которые не проходят некие тесты. Вуаля! мы изобрели Green Build Master который уже давным-давно практикуется в разработке ПО:

Принятие этого решения было весьма болезненным, т.к. вызвало множество споров, но оно того стоило, т.к. на ревью стали приходить запросы на слияние без разногласий по стилю и со временем кол-во проблемных мест стало уменьшаться.

IaC Testing

Кроме проверки стиля можно использовать и другие вещи, например, проверять что ваша инфраструктура действительно может развернуться. Или проверять что изменения в инфраструктуре не приведут к потере денег. Зачем это может понадобиться? Вопрос сложный и философский, ответить лучше байкой, что как-то был auto-scaler на Powershell который, не проверял пограничные условия => создалось больше ВМ чем надо => клиент потратил денег больше чем планировал. Приятного мало, но эту ошибку вполне реально было бы отловить на более ранних стадиях.

Можно спросить, а зачем делать сложную инфраструктуру еще сложнее? Тесты для инфраструктуры, так же, как и для кода, это не про упрощение, а про знание как ваша инфраструктура должна работать.

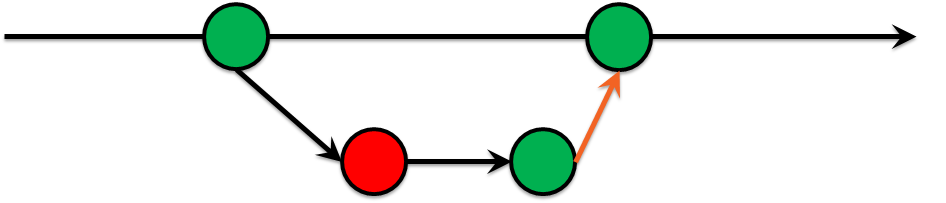

IaC Testing Pyramid

IaC Testing: Static Analysis

Если сразу разворачивать всю инфраструктуру и проверять, что она работает, то может оказаться, что это занимает уйму времени и требует кучу времени. Поэтому в основе должно быть что-то быстро работающее, его много, и оно покрывают множество примтивных мест.

Bash is tricky

Вот рассмотрим банальный пример. выбрать все файлы в текущей директории и скопировать в другое место. Первое что приходит в голову:

А что если в имени файла пробел есть? Ну ок, мы же умные, умеем пользоваться кавычками:

Молодцы? нет! Что если в директории нет ничего, т.е. глобинг не сработает.

Static analysis tools

Проблему из предыдущего шага можно было отловить когда мы забыли кавычки, для это в природе существует множество средство Shellcheck, вообще их много, и скорей всего вы сможете найти под свою IDE линтер для вашего стэка.

IaC Testing: Unit Tests

Как мы убедились из предыдущего примера, линтеры не всемогущие и не могут указать на все проблемные места. Дальше по аналогии с тестированием в разработке ПО можно вспомнить про unit tests. Тут сразу на ум приходят shunit, junit, rspec, pytest. Но что делать с ansible, chef, saltstack и иже с ними?

В самом начале мы говорили про S.O.L.I.D. и то что наша инфраструктура должна состоять из маленьких кирпичиков. Пришло их время.

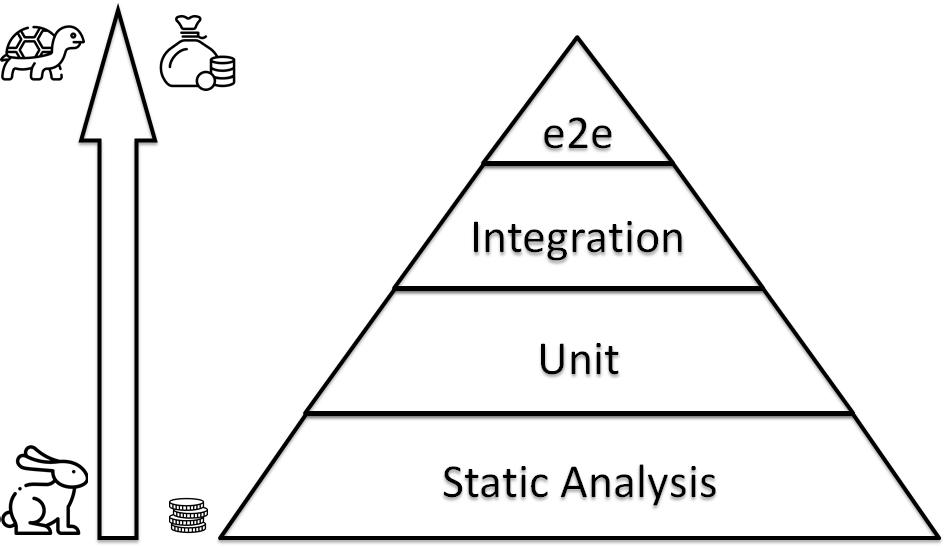

IaC Testing: Unit Testing tools

Вопрос, а что такое тесты для CFM? можно банально запускать скрипт, а можно использовать готовые решения для этого:

Что выбрать? вопрос сложный и не однозначный, вот пример изменения в проектах на github за 2018-2019 года:

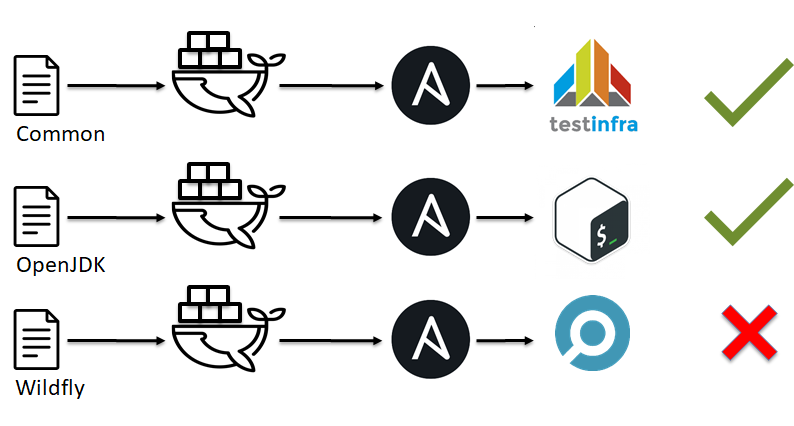

IaC Testing frameworks

Возникает как это все собрать вместе и запустить? Можно взять и сделать всё самому при наличии достаточного кол-во инженеров. А можно взять готовые решения, правда их не очень-то и много:

Пример изменения в проектах на github за 2018-2019 года:

Molecule vs. Testkitchen

Для 25-35 ролей это работало 40-70 минут, что было долго.

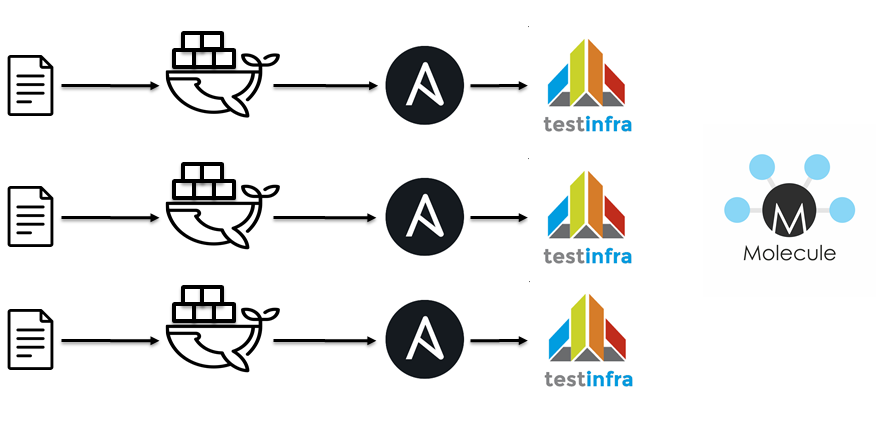

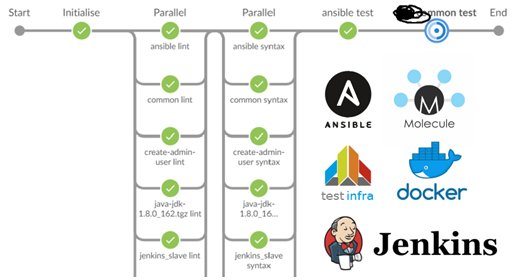

Следующим шагом стал переход на jenkins / docker / ansible / molecule. Идиологически все тоже самое

Линтовка для 40 ролей и тесты для десятка стали занимать порядка 15 минут.

Что выбрать зависит от множества факторов, как то используемый стэк, экспертиза в команде итд. тут каждый решает сам как закрывать вопрос Unit тестирования

IaC Testing: Integration Tests

На следующей ступени пирамиды тестирования инфраструктуры появлются интеграционные тесты. Они похожи на Unit тесты:

Грубо говоря, мы не проверяем работоспособность отдельного элемента системы как в unit тестах, мы проверяем как сервер сконфигурирован в целом.

IaC Testing: End to End Tests

На вершине пирамиды нас встречают End to End тесты. Т.е. мы не проверяем работоспособность отдельного сервера, отдельного скрипта, отдельного кирпичика нашей инфраструктуры. Мы проверяем что множество серверов, объединенных воедино, наша инфраструктура работает, как мы этого ожидаем. К сожалению готовых коробочных решений, мне не доводилось видеть, наверно т.к. инфраструктура зачастую уникальная и ее сложно шаблонизировать и сделать фрэймворк для ее тестирования. Как итог все создают свои собственные решению. Спрос есть, а вот ответа нет. Поэтому, расскажу что есть, чтобы натолкнуть других на здравые мысли или ткнуть меня носом, что всё давно изобретено до нас.

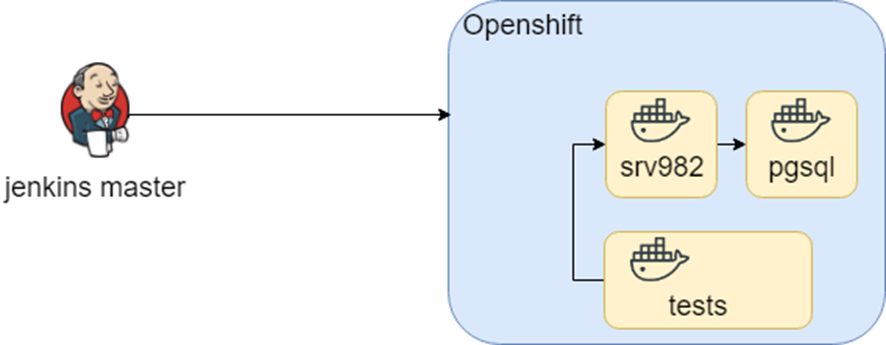

Проект с богатой историей. Используется в больших организациях и вероятно каждый из вас косвенно пересекался. Приложение поддерживает множество баз данных, интеграций итд итп. Знание о том, как инфраструктура может выглядеть это множество docker-compose файлов, а знание того, какие тесты в каком окружение запускать — это jenkins.

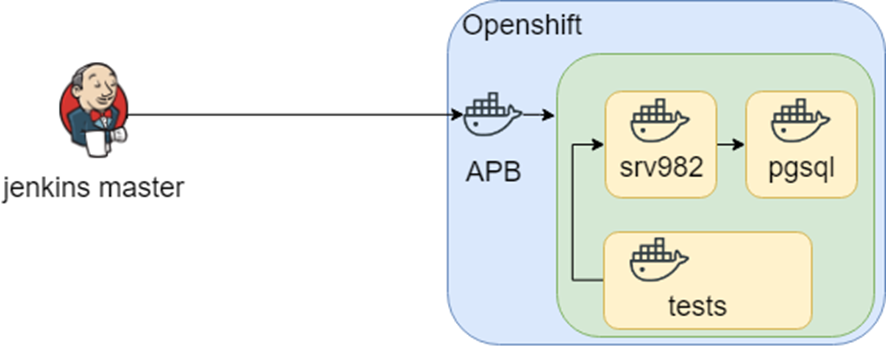

Эта схема достаточно долго работала, пока в рамках исследования мы не попробовали это перенести в Openshift. Контейнеры остались теже, а вот среда запуска сменилась (привет D.R.Y. опять).

Мысль исследования пошла дальше, и в openshift нашлась такая штука APB (Ansible Playbook Bundle), которая позволяет в контейнер запаковать знание как разворачивать инфраструктуру. Т.е. есть воспроизводимая, тестируемая точка знания, как развернуть инфраструктуру.

Всё это звучало хорошо, пока не уткнулись в гетерогенную инфраструктуру: нам для тестов нужна Windows. В итоге знание о том что, где как развернуть, и протестировать сидит в jenkins.

Conclusion

Infrastructure as Code это

What is infrastructure as code (IaC)?

Infrastructure as code (IaC) uses DevOps methodology and versioning with a descriptive model to define and deploy infrastructure, such as networks, virtual machines, load balancers, and connection topologies. Just as the same source code always generates the same binary, an IaC model generates the same environment every time it deploys.

IaC is a key DevOps practice and a component of continuous delivery. With IaC, DevOps teams can work together with a unified set of practices and tools to deliver applications and their supporting infrastructure rapidly and reliably at scale.

Avoid manual configuration to enforce consistency

IaC evolved to solve the problem of environment drift in release pipelines. Without IaC, teams must maintain deployment environment settings individually. Over time, each environment becomes a «snowflake,» a unique configuration that can’t be reproduced automatically. Inconsistency among environments can cause deployment issues. Infrastructure administration and maintenance involve manual processes that are error prone and hard to track.

IaC avoids manual configuration and enforces consistency by representing desired environment states via well-documented code in formats such as JSON. Infrastructure deployments with IaC are repeatable and prevent runtime issues caused by configuration drift or missing dependencies. Release pipelines execute the environment descriptions and version configuration models to configure target environments. To make changes, the team edits the source, not the target.

Idempotence, the ability of a given operation to always produce the same result, is an important IaC principle. A deployment command always sets the target environment into the same configuration, regardless of the environment’s starting state. Idempotency is achieved by either automatically configuring the existing target, or by discarding the existing target and recreating a fresh environment.

Deliver stable test environments rapidly at scale

IaC helps DevOps teams test applications in production-like environments early in the development cycle.В Teams can provision multiple test environments reliably on demand. The cloud dynamically provisions and tears down environments based on IaC definitions. The infrastructure code itself can be validated and tested to prevent common deployment issues.

Use declarative definition files

IaC should use declarative definition files if possible. A definition file describes the components and configuration that an environment requires, but not necessarily how to achieve that configuration. For example, the file might define a required server version and configuration, but not specify the server installation and configuration process. This abstraction allows for greater flexibility to use optimized techniques the infrastructure provider supplies. Declarative definitions also help reduce the technical debt of maintaining imperative code, such as deployment scripts, that can accrue over time.

There’s no standard syntax for declarative IaC. The syntax for describing IaC usually depends on the requirements of the target platform. Different platforms support file formats such as YAML, JSON, and XML.

Deploy IaC on Azure

Azure provides native support for IaC via the Azure Resource Manager model. Teams can define declarative ARM templates that specify the infrastructure required to deploy solutions.

Third-party platforms like Terraform, Ansible, Chef, and Pulumi also support IaC to manage automated infrastructure.

Инфраструктура как код. Введение для начинающих

Согласно отчету «State of DevOps 2019», 80% респондентов сказали, что основное приложение или служба, которую они поддерживали, было размещено на какой-то облачной платформе. 50% респондентов заявили, что их основное приложение размещено в публичном облаке.

Что такое инфраструктура как код?

Идея состоит в том, что вы относитесь к своей инфраструктуре как к программному обеспечению, а затем пишете, тестируете и выполняете код для определения, развертывания, обновления и уничтожения своей инфраструктуры.

Вы пишете код для управления своими серверами, базами данных, сетями, журналами, развертыванием и настройкой приложений. Когда вы хотите внести изменения в свою инфраструктуру, вы вносите изменения в код, тестируете его, а затем применяете его в своих системах.

Льготы

Инфраструктура как код предоставляет значительные преимущества по сравнению с ручной подготовкой:

Самообслуживание

Поскольку инфраструктура определяется как код, весь процесс и развертывание могут быть автоматизированы и могут быть запущены любым пользователем в команде DevOps. Пользователи инфраструктуры получают ресурсы, которые им нужны, когда им это нужно.

Идемпотентность

Идемпотентность означает, что вы определяете желаемое состояние, и независимо от того, сколько раз вы запускаете скрипт, результат будет одинаковым. Он проверяет текущее и желаемое состояние и применяет только те изменения, которые необходимы. Этого может быть чрезвычайно трудно достичь с помощью скриптов bash.

Такие инструменты, как Ansible и Terraform, имеют встроенные функции, которые делают ваш код идемпотентным.

Снижение затрат

Сокращает время и усилия, необходимые для предоставления, намного меньше, чем подготовка вручную.

Более быстрая доставка программного обеспечения

Быстрое предоставление инфраструктуры для разработки, тестирования и производства позволяет значительно быстрее доставлять программное обеспечение. Поскольку процесс развертывания автоматизирован, он также последовательный и повторяемый.

Самодокументирование

Состояние инфраструктуры определяется в коде, который легко читается любым человеком.

Контролируемая версия

Традиционно изменения в производственных системах считаются рискованными. Но тогда изменения неизбежны. Вам может потребоваться добавить новую базу данных при добавлении новой функции. Вам может потребоваться добавить новые серверы или хранилище в кластер. Инфраструктура как код уменьшает усилия и риск внесения изменений в инфраструктуру.

Вы можете проверить свои исходные файлы в системе управления версиями, что означает, что вы можете отслеживать все изменения, внесенные в инфраструктуру, и быстро возвращаться к предыдущей версии, если что-то сломается.

Валидация и тестирование

Инфраструктура как код позволяет постоянно тестировать и применять небольшие изменения. Поскольку все является кодом, вы можете проверять ошибки, используя статический анализ и автоматические тесты.

Улучшенная безопасность

Переход к инфраструктуре в виде кода позволяет встроить систему безопасности с самого начала, а затем вы можете надежно и безопасно применять изменения.

What is Infrastructure as Code (IaC)?

Overview

Infrastructure as Code (IaC) is the managing and provisioning of infrastructure through code instead of through manual processes.

With IaC, configuration files are created that contain your infrastructure specifications, which makes it easier to edit and distribute configurations. It also ensures that you provision the same environment every time. By codifying and documenting your configuration specifications, IaC aids configuration management and helps you to avoid undocumented, ad-hoc configuration changes.

Version control is an important part of IaC, and your configuration files should be under source control just like any other software source code file. Deploying your infrastructure as code also means that you can divide your infrastructure into modular components that can then be combined in different ways through automation.

Automating infrastructure provisioning with IaC means that developers don’t need to manually provision and manage servers, operating systems, storage, and other infrastructure components each time they develop or deploy an application. Codifying your infrastructure gives you a template to follow for provisioning, and although this can still be accomplished manually, an automation tool, such as Red Hat ® Ansible ® Automation Platform, can do it for you.

Declarative vs. imperative approaches to IaC

There are 2 ways to approach IaC: declarative or imperative.

A declarative approach defines the desired state of the system, including what resources you need and any properties they should have, and an IaC tool will configure it for you.

A declarative approach also keeps a list of the current state of your system objects, which makes taking down the infrastructure simpler to manage.

An imperative approach instead defines the specific commands needed to achieve the desired configuration, and those commands then need to be executed in the correct order.

Many IaC tools use a declarative approach and will automatically provision the desired infrastructure. If you make changes to the desired state, a declarative IaC tool will apply those changes for you. An imperative tool will require you to figure out how those changes should be applied.

IaC tools are often able to operate in both approaches, but tend to prefer 1 approach over the other.

Benefits of IaC

Provisioning infrastructure has historically been a time consuming and costly manual process. Now infrastructure management has moved away from physical hardware in data centers, though this still may be a component for your organization, to virtualization, containers, and cloud computing.

With cloud computing, the number of infrastructure components has grown, more applications are being released to production on a daily basis, and infrastructure needs to be able to be spun up, scaled, and taken down frequently. Without an IaC practice in place, it becomes increasingly difficult to manage the scale of today’s infrastructure.

IaC can help your organization manage IT infrastructure needs while also improving consistency and reducing errors and manual configuration.

Benefits:

What’s the difference between Ansible and Red Hat Ansible Automation Platform?

IaC tools

Server automation and configuration management tools can often be used to achieve IaC. There are also solutions specifically for IaC.

These are a few popular choices:

Ansible Automation Platform can be used to provision operating systems and network devices, deploy applications, and manage configuration.

Why does IaC matter for DevOps?

IaC is an important part of implementing DevOps practices and continuous integration/continuous delivery (CI/CD). IaC takes away the majority of provisioning work from developers, who can execute a script to have their infrastructure ready to go.

That way, application deployments aren’t held up waiting for the infrastructure, and sysadmins aren’t managing time-consuming manual processes.

CI/CD relies on ongoing automation and continuous monitoring throughout the application lifecycle, from integration and testing to delivery and deployment.

In order for an environment to be automated it needs to be consistent. Automating application deployments doesn’t work when the development team deploys applications or configures environments one way and the operations teams deploys and configures another way.

Aligning development and operations teams through a DevOps approach leads to fewer errors, manual deployments, and inconsistencies.

IaC helps you to align development and operations because both teams can use the same description of the application deployment, supporting a DevOps approach.

The same deployment process should be used for every environment, including your production environment. IaC generates the same environment every time it is used.

IaC also removes the need to maintain individual deployment environments with unique configurations that can’t be reproduced automatically and ensures that the production environment will be consistent.

DevOps best practices are also applied to infrastructure in IaC. Infrastructure can go through the same CI/CD pipeline as an application does during software development, applying the same testing and version control to the infrastructure code.

Why choose Red Hat for automation?

Creating an enterprise-wide approach to automation lets you automate not only IT processes, but also entire technologies, teams, and organizations.

Red Hat® Ansible® Automation Platform includes all the tools needed to implement enterprise-wide automation, including playbooks, a visual dashboard, and analytics. Ansible Automation Platform also uses webhooks to to automate IaC workflows and enable GitOps practices.

Ansible Playbooks, written in YAML, describe the desired state of your systems, which are usually kept in source control. Ansible Automation Platform does the work of getting your systems to the desired state, no matter their current state.

Ansible Automation Platform makes your installations, upgrades and day-to-day management repeatable and reliable.

With the right automation solution in place, you can deploy new applications and services faster, manage IT infrastructure more efficiently, and see an increase in app development productivity.

Keep reading

Learning Ansible basics

Ansible automates IT processes like provisioning and configuration management. Learn the basics of Ansible with this introduction to key concepts.

What is business process management?

Business process management (BPM) is the practice of modeling, analyzing, and optimizing end-to-end business processes to meet your strategic business goals.

Why choose Red Hat for automation?

Red Hat Ansible Automation Platform includes all the tools needed to share automation across teams and implement enterprise-wide automation.

More about automation

Products

Engagements with our strategic advisers who take a big-picture view of your organization, analyze your challenges, and help you overcome them with comprehensive, cost-effective solutions.

A platform for implementing enterprise-wide automation, no matter where you are in your automation journey

A platform for developing cloud-native applications that automate business decisions and processes.

Инфраструктура как код

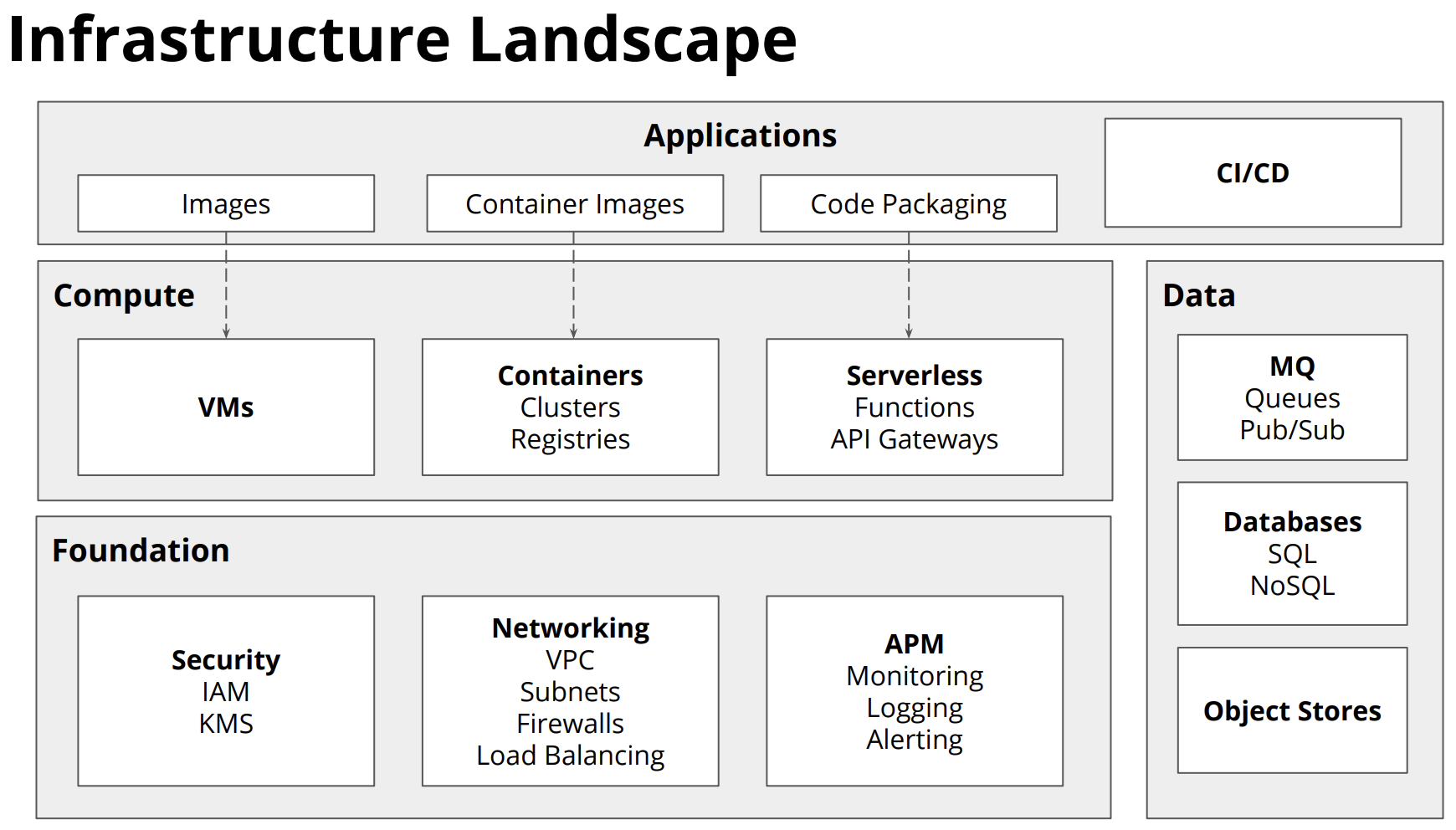

Облачные системы используют микрослужбы, контейнеры и современные системы для достижения скорости и гибкости. Они предоставляют автоматизированные этапы сборки и выпуска для обеспечения согласованного и качественного кода. Но это только часть истории. Как подготовить облачные среды, на которых работают эти системы?

Такие средства, как Azure Resource Manager (ARM), Terraform и интерфейс командной строки Azure (CLI), позволяют декларативно создавать сценарии необходимой облачной инфраструктуры.

Шаблоны Azure Resource Manager

ARM означает Azure Resource Manager. Это модуль подготовки API, встроенный в Azure и предоставляемый в качестве службы API. ARM позволяет развертывать, обновлять, удалять и администрировать ресурсы, содержащиеся в группе ресурсов Azure, в рамках одной скоординированной операции. Вы предоставляете обработчик шаблону на основе JSON, который указывает необходимые ресурсы и их конфигурацию. ARM автоматически управляет развертыванием в правильном порядке с учетом зависимостей. Подсистема обеспечивает идемпотентность. Если требуемый ресурс уже существует с той же конфигурацией, подготовка будет проигнорирована.

Шаблоны Azure Resource Manager — это язык на основе JSON для определения различных ресурсов в Azure. Базовая схема выглядит примерно так: рис. 10-14.

В этом шаблоне можно определить контейнер хранилища в разделе ресурсов следующим образом:

Шаблон ARM можно параметризовать с помощью динамической среды и сведений о конфигурации. Это позволяет повторно использовать его для определения различных сред, таких как разработка, QA или рабочая среда. Как правило, шаблон создает все ресурсы в одной группе ресурсов Azure. При необходимости можно определить несколько групп ресурсов в одном шаблоне Resource Manager. Вы можете удалить все ресурсы в среде, удалив саму группу ресурсов. Анализ затрат также может выполняться на уровне группы ресурсов, что позволяет быстро учитывать стоимость каждой среды.

В проекте шаблонов быстрого запуска Azure на сайте GitHub доступно множество примеров шаблонов ARM. Они могут помочь ускорить создание нового шаблона или изменить существующий.

Шаблоны Resource Manager можно запускать различными способами. Возможно, самый простой способ — просто вставить их на портал Azure. Для экспериментальных развертываний этот метод может быть быстрым. Они также могут выполняться как часть процесса сборки или выпуска в Azure DevOps. Существуют задачи, которые будут использовать подключения к Azure для запуска шаблонов. Изменения шаблонов Resource Manager применяются постепенно, то есть для добавления нового ресурса требуется только добавить его в шаблон. Средства будут согласовывать различия между текущими ресурсами и теми, которые определены в шаблоне. Затем ресурсы будут созданы или изменены, чтобы они соответствовали тому, что определено в шаблоне.

Terraform

Terraform — это коммерческое средство создания шаблонов, которое может подготавливать собственные облачные приложения для всех основных облачных игроков: Azure, Google Cloud Platform, AWS и AliCloud. Вместо того чтобы использовать JSON в качестве языка определения шаблона, он использует немного более подробный HCL (язык конфигурации Hashicorp).

Пример файла Terraform, который выполняет то же самое, что и предыдущий шаблон Resource Manager (рис. 10-15), показан на рисунке 10-16:

Terraform также предоставляет интуитивно понятные сообщения об ошибках для шаблонов проблем. Существует также удобное задание проверки, которое можно использовать на этапе сборки для раннего перехвата ошибок шаблона.

Как и в случае с шаблонами Resource Manager, средства командной строки доступны для развертывания шаблонов Terraform. В Azure Pipelines также есть задачи, созданные сообществом, которые могут проверять и применять шаблоны Terraform.

Иногда Terraform и шаблоны ARM выводить значимые значения, например строку подключения к вновь созданной базе данных. Эти сведения можно записать в конвейер сборки и использовать в последующих задачах.

Скрипты и задачи Azure CLI