Как сделать дата центр дома

Как сделать дата центр дома

В декабре 2008 года открывают руофф, я отказываюсь от Ultima Online и World of Warcraft в пользу Lineage 2 руофф, в феврале 2009 года отказываюсь от Lineage 2 на европейских серверах, в марте первый мой сотрудник увольняется и становить моим конкурентом, чуть позже он же разместит у меня в дата центре свои сервера и еще чуть позже возьмет в аренду дополнительные сервера. Тем самым я полностью перешел на дистанционных сотрудников, в августе я нанял еще двух удаленных сотрудников, один из которых был специалистом для EVE Online, в декабре 2009 я нанимаю еще двух специалистов для Aion, в январе 2010 два сотрудника решают самостоятельно начать работать на себя, арендуют у меня 7 компьютеров. В июле 2010 года в моем дата центре размещено чуть меньше 100 компьютеров и чуть больше 50 сдано в аренду, большая часть моих клиентов стали мои коллеги по Ultima Online, World of Warcraft, Everquest, R2 Online, Ragnarok Online, Perfect World и многие другие, а также их друзья и знакомые, а также друзья друзей и знакомые знакомых. К сожалению у меня в команде началась текучка кадров, одни специалисты уходили, другие приходили, кто-то потом брал в аренду сервера, а кто-то понимал, что это не его и пропадал в просторах интернета. В декабре 2010 года я принял непростое для себя решение, закончить с ботоводством, гейм мастеры становились умнее с каждым баном, текучка кадров увеличивала обороты, а так как по на туре я творческий и добропорядочный человек и в каких-то моментах очень щепетильный, я не смог морально пережить блокировки моих аккаунтов без стресса и разочарования.

Дата центр своими руками или как сделать ЦОД. рис. 9 | Уважаемые читатели, не повторяйте моих ошибок, размещайте свои компьютеры там где именно для них созданы условия для круглосуточной работы, помните поговорку, скупой платит дважды. |

Решил я обезопасить и сделать более комфортным свое жилище. Обезопасить — это потому, что у меня инет канал обычно не пустует, зачем ему зря пропадать, как говориться, а меня иногда не бывает дома — а комп работает — я случаев таких не знаю, но есть вероятность воспламенения компьютера. Более комфортным — это понятно — нет ночного гула.

Начнем с железной части.

Так как дело происходит зимой, то главный вопрос, который возникает — а выдержит ли холода система.

На одном форуме доказывал человек о стойкости железа к морозам, приводя в пример системы моментальных платежей, аргументируя это тем, что в них находятся обычные комплектующие.

Я решил проверить это. Сначала я поставил системник (pentium 1200 с 512 Mb DIMM) просто голым, проведя предварительно питание и сеть, больше ничего не надо. Проработал ночь при 0 градусов на улице (балког застеклен, не не утеплен), с утра отвалился, пинги не шли, но все крутилось. Думал — холодно ему, надо сделать ящик, да и от внешнего воздействия не помешает. Сделали ящик, попутно устанавливая софт, все это заняло около недели.

Поставлен debian etch — единственный дистрибутив, который у меня был 32 битным. Иксы ставить не стал, ибо незачем =). Настроил sshd, samba (подключен сетевой диск с шарой к винде), для закачек поставлен дополнительный винт 80 Гб, который отформатирован в файловую систему reiser fs; apache, установлен rtorrent, последний из svn, как написано тут, но wtorrent ставить не стал — точнее поставил, но отказался, нашел более интересную веб морду — называется ruTorrent, практически аналог utorrenta, но в вебе, почти все на яваскрипте, ниже скрин.

Текущая версия ruTorrent — 1.6, на скрине 0.1. Единственный момент — пришлось скачать по ссылке файлик settings.txt и поместить его в папку settings.

Веб мордочка очень понравилась.

Единственный минус, правда это минус самого rtorrent — нет очереди закачки. Но есть приоритеты и ограничения глобальных слотов скачки. В принципе, это тоже самое.

Вернемся к железной части. Когда все было готово, ящик покрашен и высушен, пришла пора проверить его в деле. Вот он собственно сам:

А вот как устроена связь:

Процесс размещения системы в стойке =) Естественно, комп был прогрет дома и запущен сразу.

А вот так он выглядит в боевом состоянии:

Так вот, первый заход оказался неудачным — те же симптомы, что и при первой пробе, но быстрее, ибо температура на улице минус 10 градусов — пинг пропадает, хотя по звуку все крутится. Проработал полчаса, вот температура, снятая сенсорами каждые 5-10 минут:

M/B Temp: +17°C (high = +105°C, hyst = +0°C)

CPU Temp: +36.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +14°C (high = +105°C, hyst = +0°C)

CPU Temp: +29.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +13°C (high = +105°C, hyst = +0°C)

CPU Temp: +28.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +13°C (high = +105°C, hyst = +0°C)

CPU Temp: +27.0°C (high = +100°C, hyst = +92°C)

Дальше он не отвечал на запросы.

Вернул системник назад — открыл — потрогал руками самые холодные места — сетевая была самой холодной.

Это было какая-то сетевушка под названием complex, очевидно качество не очень. Решил заменить, нашел acorp с чипом realtek.

Что предпочесть: свой дата-центр, colocation или аренду вычислительных ресурсов?

M/B Temp: +14°C (high = +105°C, hyst = +0°C)

CPU Temp: +34.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +13°C (high = +105°C, hyst = +0°C)

CPU Temp: +27.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +12°C (high = +105°C, hyst = +0°C)

CPU Temp: +26.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +11°C (high = +105°C, hyst = +0°C)

CPU Temp: +25.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +11°C (high = +105°C, hyst = +0°C)

CPU Temp: +26.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +11°C (high = +105°C, hyst = +0°C)

CPU Temp: +25.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +10°C (high = +105°C, hyst = +0°C)

CPU Temp: +25.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +10°C (high = +105°C, hyst = +0°C)

CPU Temp: +27.0°C (high = +100°C, hyst = +92°C)

M/B Temp: +10°C (high = +105°C, hyst = +0°C)

CPU Temp: +23.0°C (high = +100°C, hyst = +92°C)

Концепция проекта

Прежде всего должна быть разработана концепция: Что из себя представляет проект, Основные задачи, Целевая аудитория, Методы монетизации.

Пример моего проекта. Введение связанное с названием и изюминку проекта я опускаю.

Далее идет приблизительное описание: проект представляет комплекс сервисов для домохозяек. Целевая аудитория: Женщины 20-45 лет, как правило сидят дома с детьми. Что им нужно? Их интересы:

Во первых дать комплекс средств по предоставлению свежей информации по интересам, как правило это могут быть RSS каналы с других сайтов.

Во вторых им нужно общение между собой: чат, форум, мессенжер, блоги.

В третьих им нужно средство для выражения самореализации: блоги, фото-альбомы.

Необходимо охватить информацию по рубрикам: Дом и семья, Красота и здоровье, Покупки, Разводы и как пережить одиночество, Деловая женщина.

Финансовая составляющая проекта

Это самый главный раздел для инвесторов. Должно быть два раздела: Расходы и Доходы.

Расходная часть имеет две составляющей, единовременые расходы: (покупка серверов)

и постоянные: аренда серверов и каналов( хостинг или колокейшен), з/п персонала (контент-менеджеров, поддержка проекта, модератеров)

Прототип проекта

Самое главное — это предоставить инвестору прототип рабочего проекта. Если проект не большой и умещается в рамках шаринг-хостинга, это не проблема. Если проект амбициозный, расчитан на высокую нагрузку и представляет распределенный кластер серверов, то как вариант — это организация собственного домашнего Дата-центра. Проект должен «задышать» в ваших руках и «ожить» в глазах инвесторов.

Несомненно прежде чем реализовывать проект, необходимо оговорить с провайдером тариф, узнать полосу пропускания как входящего, так и исходящего трафика, и конечно должен быть выделенный IP адрес. Пока мой трариф 15 Mbit трафика.

Архитектура проекта разработана таким образом, что в случае «взлета» проекта, его можно было безболезненно разнести на несколько серверов. Каждая функциональная единица имеет свой поддомен. Впрочем, архитектура проекта — это отдельная тема другого блога.

Одна из возможных схем расположения серверов проекта представлена на рис 1.

Сервер 1 является прокси сервером и WEB. Сервер 2 является сервером БД, который должен быть в одной локальной сети с Сервером 1 (черный цвет). Сервер 3 — это скриптовый сервер, на нем запускаются разные бэдграундовские скрипты, которые осуществляют поиск информации в интернете и обрабатывают пользовательский контент. В идеале, Срвер 3 должен иметь отдельный доступ в интернет, но «на безрыбье и рак рыба». Сервер 3 подключается через домашний роутер, ну и конечно через этот же роутер подключается мой ноут, как сервер разработчика, так и компьютер жены.

Издержки и железо

На сегодняшний день издержки составляют:

разовые:

регистрация домена 650 руб,

две сетевых карты 220 х 2 = 440 руб

апгрейд памяти — 1500 руб

Переменные:

удорожание тарифа + 500 руб

Как видите, такие издержки может вполне позволить даже начинающий программист бизнесмен.

Состояние дел и возможный исход событий

и так: Не ошибается тот, кто ничего не делает

и Кто не рискует, тот не пьет шампанского

Как я строил свой датацентр — часть первая, подготовительная

Как известно, любой стартап начинается с фразы «Как же вы за***ли, лучше сам сделаю лучше».

В 2007 году положение с датацентрами в Москве, да и во всей России было критическим. Попасть туда простому хостеру можно было только по предварительной записи. Драли с него втридорога, сервера частенько перегревали, электричество периодически отсутствовало, и еще, стоило датацентру начать генерировать 2-3 гигабита полосы, как он тут же воображал себя царем горы, пытался барыжить твоим трафиком, а с несогласными боролся методом пускания моего трафика через узкий зашейпенный канал ***телекома зарубеж.

А общение с ночными дежурными датацентра — это отдельная песня. Чаще всего было проще приехать и самому найти вывалившийся патчкорд, чем полночи пытаться добиться от мало вменяемого, ничего не хотящего юноши. И это хорошо, если дежурный был и попасть в датацентр ночью было возможно. Некоторые датацентры работали с 9 до 5, кроме праздников и выходных дней. Все остальное время там не было НИКОГО. Сервер, упавший в пятницу вечером, пролежит, минимум, до дня понедельника.

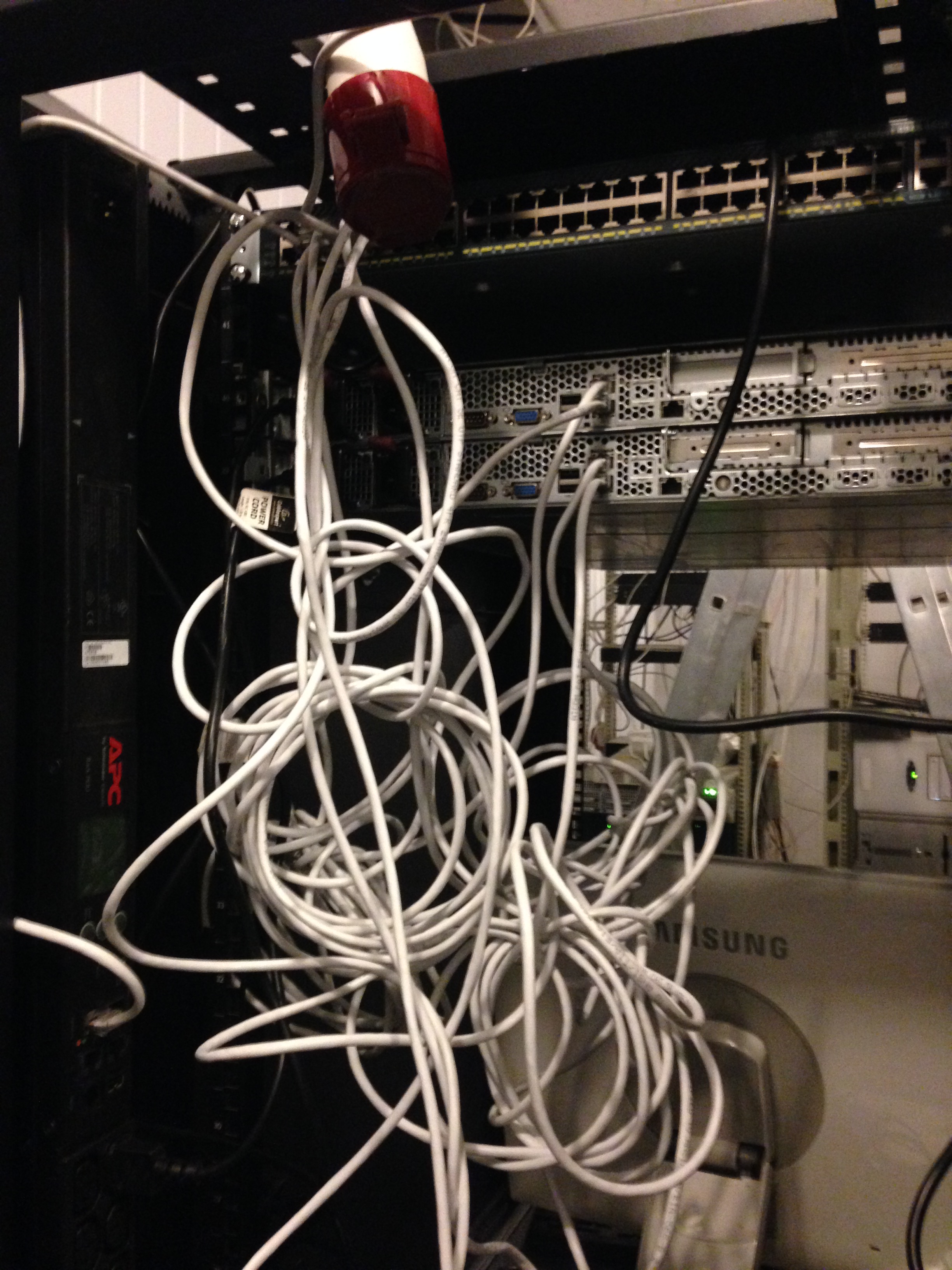

Картинка, о том, что творилось внутри типичного датацентра того времени.

Мне, к тому времени, это порядком надоело, и, как выход, я решил строить свой датацентр, ориентированный на запросы меня и моих пользователей.

А именно хотелось:

1) Нормального, качественного охлаждения с большим запасом на случай выхода одного из кондиционеров.

2) Беспроблемного электричества и обязательно собственный дизель.

3) Каналы и до местных Tier1 и до пира. Трафик должен стоить нормальных денег.

4) Своей, вышколенной и вменяемой круглосуточной смены на площадке.

Своими мыслями я делился с знакомыми и нашел сочувствующих. Был написан бизнес план. Не спеша были найдены деньги на запуск и клиенты, что бы не работать в минус после запуска.

Был найден и будущий исполнитель строительства датацентра — Группа компаний «Радиус»

Итак прошел весь 2008 год. Зимой количество объектов вдруг резко увеличилось, а арендодатели вдруг стали соглашаться на наши условия, и в январе 2009 года помещение было найдено. Представляло оно из себя не очень приятное зрелище.

Приблизительно вот такое

И с другой стороны

Итак, договор аренды подписан, мы с специалистами группы компаний Радиус засучили рукава и начали делать рабочий проект. Большой такой, талмуд, страниц на 1000. В котором подробно описали как сделать из того, что есть, красоту необыкновенную, нужную нам. К марту проект был готов, и началась стройка.

Как всегда, самое интересное в следующей серии

Оборудование и идеи для малого бизнеса

Форум про бизнес и идеи производства

Открытие дата-центра.

Предложу достаточно специфичный вид бизнеса. Он не подойдет каждому пятому, да и каждому двадцатому тоже. Открытие своего дата-центра и обслуживание клиентов. У данного направления отличные перспективы для развития, особенно в регионах. Ситуация с данным видом услуг лучше чем десять лет назад, в Москве уже не приходится выбирать из нескольких. Вариантов достаточно.

А вот в провинциях конкурентов практически нет. Этому есть ряд объяснений:

А. Довольно большие капиталовложения

Б. Сложно в технической реализации

В. Недостаток грамотных специалистов

Дата-центр – центр для хранения и обработки данных (в простонародье ЦОД). Специальное помещение/здание для хостинга сетевого или серверного оборудования.

Основные характеристики – уровень безопасности, надежности. Так называемы Tier. Существует 4 типа, которые имеют соответствующую нумерацию: Tier I.. Tier IV. Четвертая самая-самая. Если в первом типе даже не предусмотрено резервирование данных, то в последнем полная автономность и отказоустойчивость.

Чем выше степень надежности, тем больше средств понадобится на открытие. Оптимально ориентироваться на III. Формат достаточно распространненый в мировой практике.

Найти помещение, желательно на первом этаже. Только долгосрочная аренда и возможность капитального ремонта. Желательно от 300 квадратных метров. Так же лучше, чтобы в помещениях не пролегали разные магистрали (после обустройства получить к ним доступ будет проблематично).

Работ по обустройство помещения понадобится много. Создание гермозоны. Установка системы пожаротушения. Протяжка отдельной магистрали (электричество), поэтому рядом должна быть трансформаторная, которая может дарить минимум по 700 kW.

Установка мощной системы кондиционирования. Системы бесперебойного питания (за счет специального оборудования) + запасной дизель.

Цифры в голове уже побежали, у меня не получается даже примерно посчитать сколько необходимо на ряд подобных действий.

Теперь само оборудование внутри, коммутаторы, серверные стойки, сервера. Прокладка оптоволокна, соединение все в единый механизм. На все это так же требуются приличные деньги.

После наладки всей системы, придется ждать в гости министерство связи для выдачи заключения. А далее путем рекламы привлекать на аренду своих мощностей или для размещения оборудования клиентов. Без сайта не обойтись и без вливания средств в рекламную компанию тоже. Причем она должна быть профильной и нацеленной на конкретную аудиторию. Так что не все способы подойдут. Тут стоит разрабатывать целый план.

Так же при работе стоит учитывать, что работать ЦОД должен круглосуточно, сбои бывают везде, поэтому в любое время суток в помещениях должен находится дежурный администратор. Это еще как минимум 3 человека. И лучше, чтобы это были не студенты, а профессионалы, так как репутация в данном вопросе важна. Хоть конкуренция и не велика, но никто не помешает неудовлетворенной фирме сделать свою серверную.

У меня нет даже приблизительных расчетов, какой суммой надо обладать. Точнее знаю, что несколько миллионов это минимум, который взят по ценникам до кризиса. Но перспективы развития я вижу огромные. Клиент будет идти и будет пользоваться, так как дата-центры только начинают входить в жизнь отечественных компаний.

Как мы строили свой мини ЦОД. Часть 1 — Colocation

Здравствуйте коллеги и жители Хабра. Хотим рассказать Вам историю одной небольшой компании от начала её становления до текущих реалий. Хотим сразу сказать, что данный материал сделан для людей, которым интересна эта тематика. Прежде чем это написать (и задолго до этого) мы пересмотрели множество публикаций на Хабре о строительстве ЦОДов и это очень помогло нам в реализации наших идей. Публикация будет разделена на несколько этапов нашей работы, от аренды шкафа до финала постройки собственного мини-цода. Надеюсь и эта статья поможет хотя бы одному человеку. Поехали!

Поехали

В 2015 году, в Украине была создана хостинг-компания с большими амбициями на будущее и фактическим отсутствием стартового капитала. Оборудование мы арендовали в Москве, у одного из известных провайдеров (и по знакомству), это и дало нам начало развития. Благодаря нашему опыту и отчасти везению, уже в первые месяцы мы набрали достаточно клиентов, чтобы купить собственное оборудование и обзавестись хорошими связями.

Мы долго выбирали оборудование, которое нам нужно для собственных целей, выбирали сначала по параметрам цена/качество, но к сожалению большинство известных брендов (hp, dell, supermicro, ibm) все очень неплохи по качеству и схожи по цене.

Тогда мы пошли другим путем, выбирали из того что есть в Украине в наличии в больших количествах (на случай поломок или замены) и выбрали HP. Супермикро (как нам казалось) очень неплохо конфигурируются, но к сожалению их цена в Украине превышала всякий адекватный смысл. Да и запчастей было не так много. Так мы и выбрали, то что выбрали.

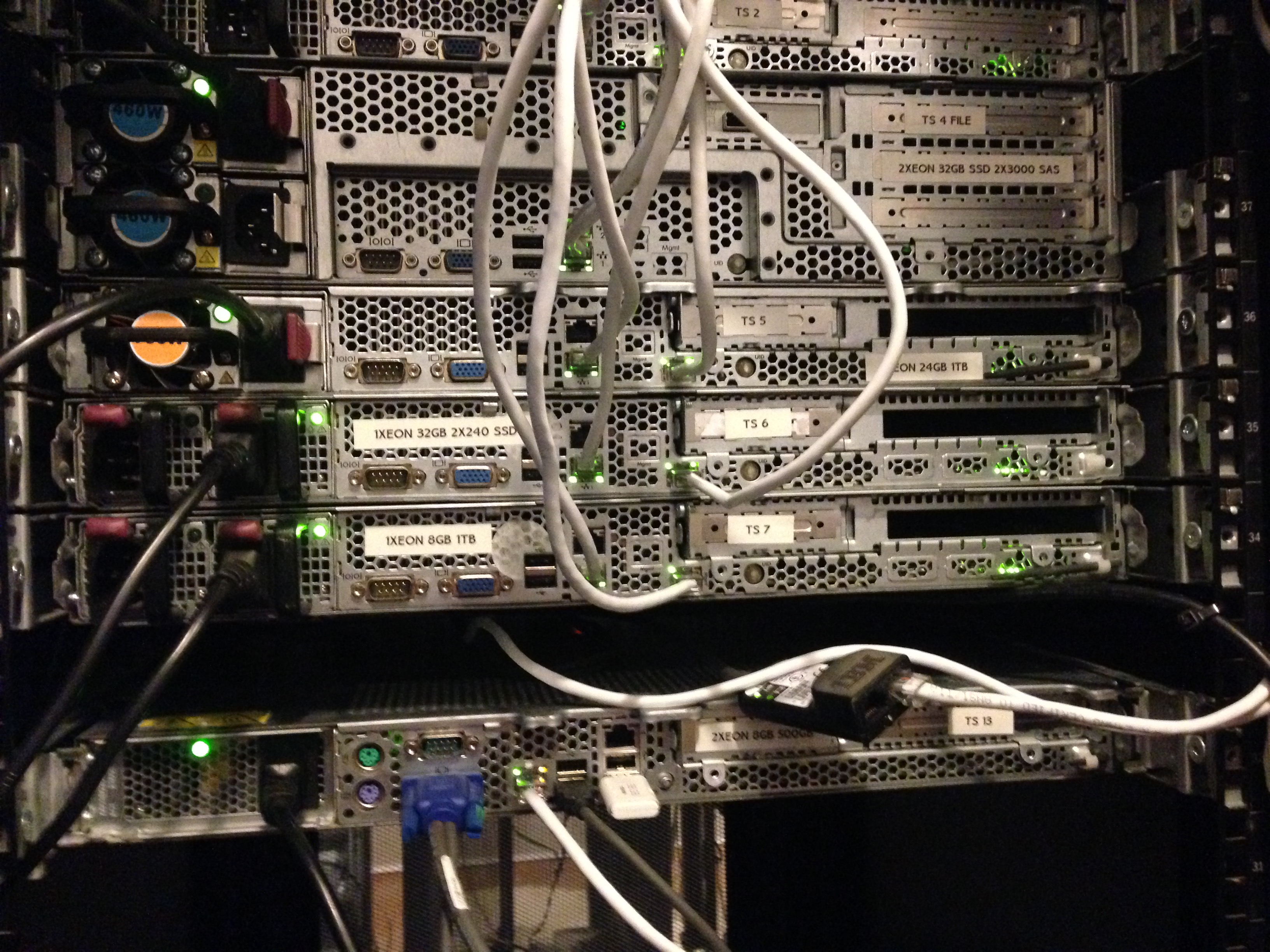

Первое железо

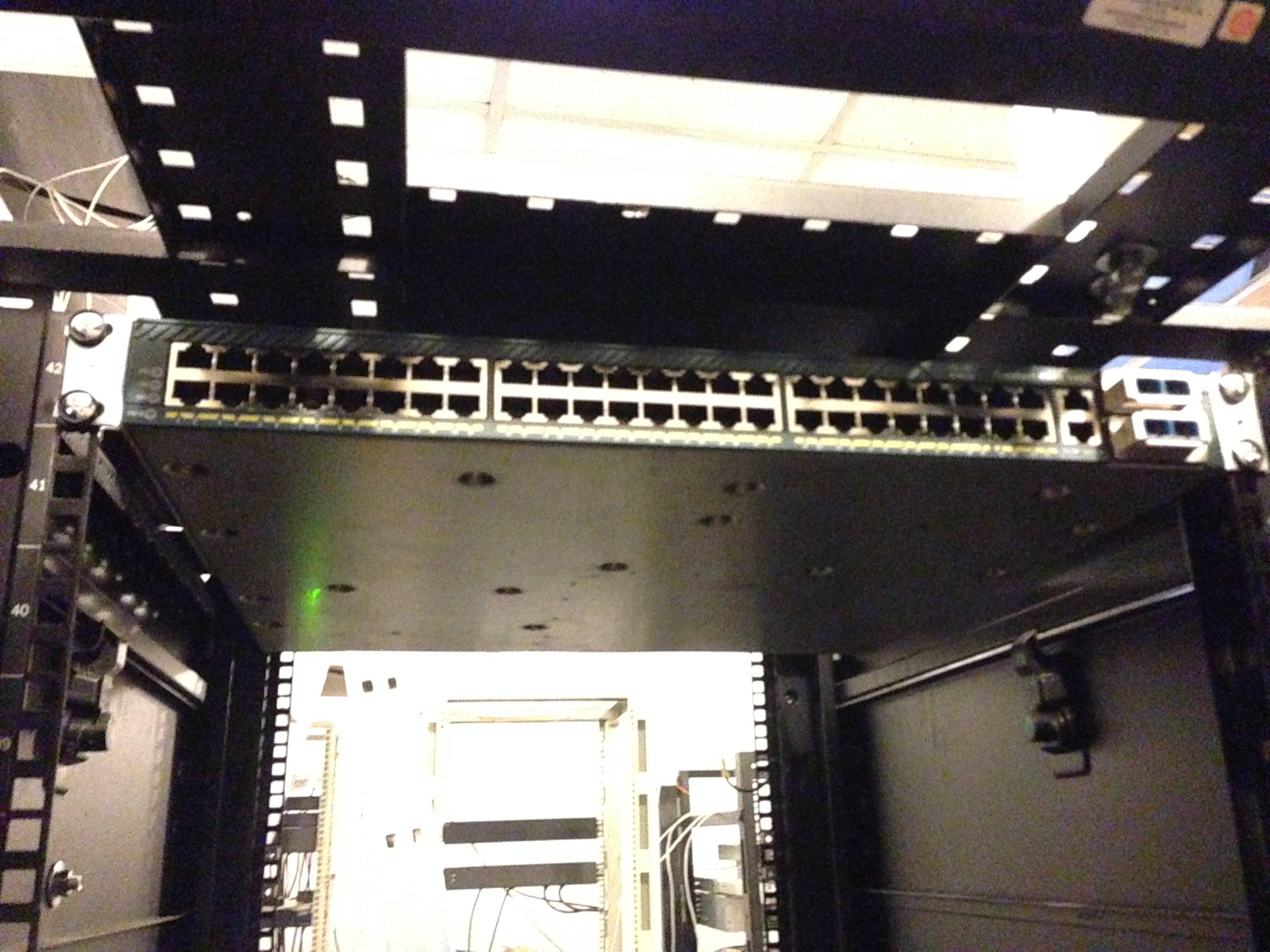

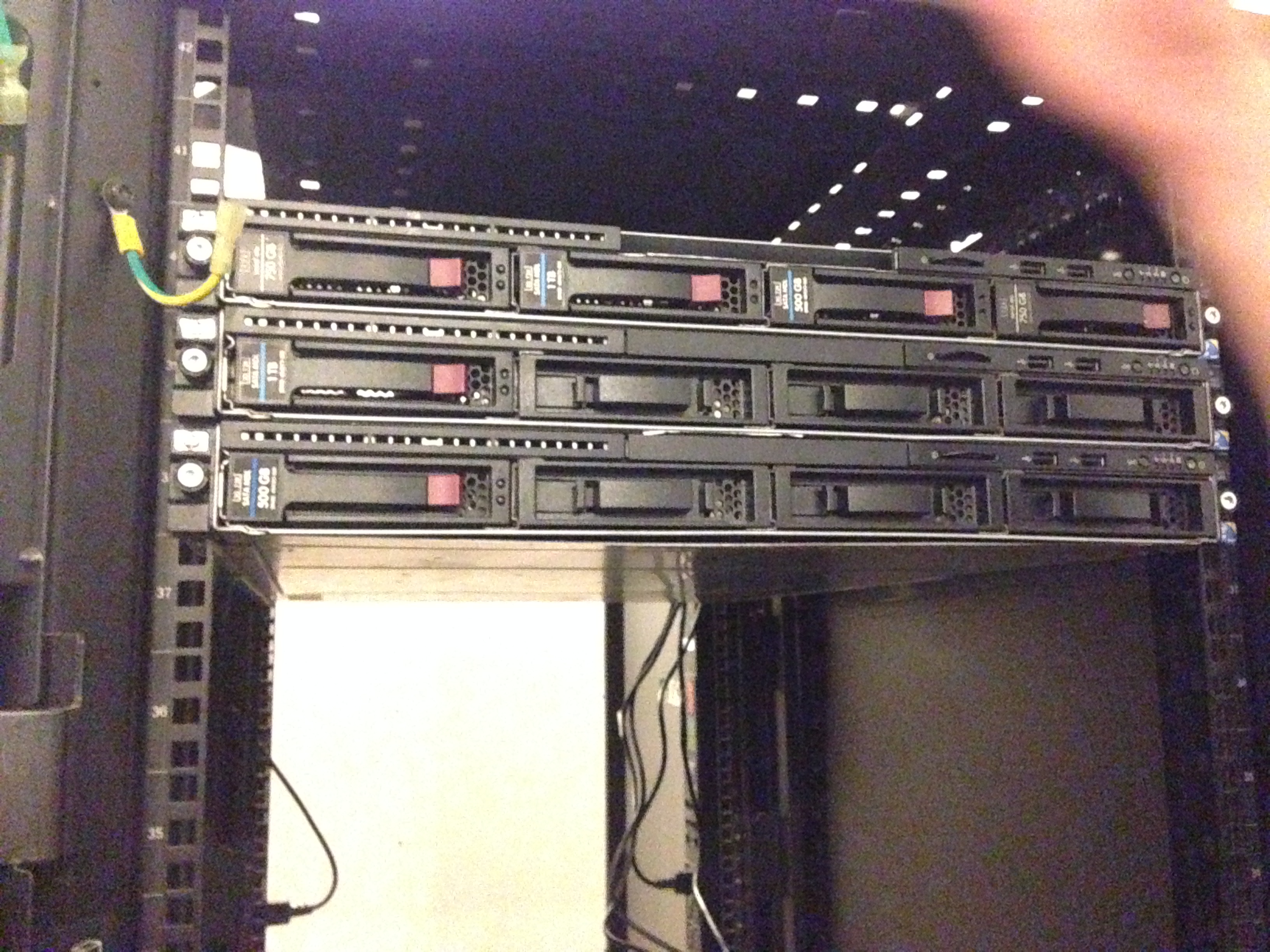

Мы арендовали шкаф в Днепропетровском дата-центре и приобрели Cisco 4948 10GE (на вырост) и первые три сервера HP Gen 6.

Выбор оборудования HP, впоследствии нам очень помог, за счет своего низкого энергопотребления. Ну а дальше, пошло-поехало. Приобрели управляемые розетки (PDU), они нам были важны для отсчета энергопотребления и управления серверами (авто-инсталл).

Уже потом мы поняли что взяли не те PDU которые управляются, а просто измерительные. Но благо HP имеет встроенное iLO (IPMI) и это нас спасло. Мы сделали всю автоматизацию системы при помощи IPMI (через DCI Manager). После был приобретен некоторый инструментарий для прокладки СКС и мы потихоньку начали строить нечто большее.

Здесь мы видим APC PDU (которые оказались не управляемыми), подключаем:

Вот так, кстати мы установили третий сервер и PDU (справа и слева). Сервер долго служил нам подставкой под монитор и клавиатуру с мышкой.

На имеющемся оборудовании мы организовали некий Cloud сервис при помощи VMmanager Cloud от компании ISP Systems. У нас было три сервера, один из которых был мастером, второй — файловым. Фактическое резервирование у нас было на случай падения одного из серверов (за исключением файлового). Мы понимали что 3 сервера для облака это мало, поэтому доп. оборудование уже было в пути. Благо «доставлять» в облако его можно было без проблем и особых настроек.

При падении одного из серверов (мастера, или второго резервного) — облако спокойно мигрировало туда и обратно без падений. Мы специально тестировали это перед вводом в продакшн. Файловый сервер у нас был организован на неплохих дисках в аппаратном RAID10 (для скорости и отказоустойчивости).

На тот момент у нас было несколько нод в России на арендованном оборудовании, которые мы бережно начали переносить на наш новый Cloud сервис. Очень много негатива было высказано поддержке компании ISP Systems, т.к. адекватной миграции из VMmanager KVM в VMmanager Cloud сделано ими не было, а по итогу нам вообще сказали что этого и не должно быть. Переносили ручками, долго и кропотливо. Разумеется перенесли лишь тех кто согласился на акционное размещение и перенос.

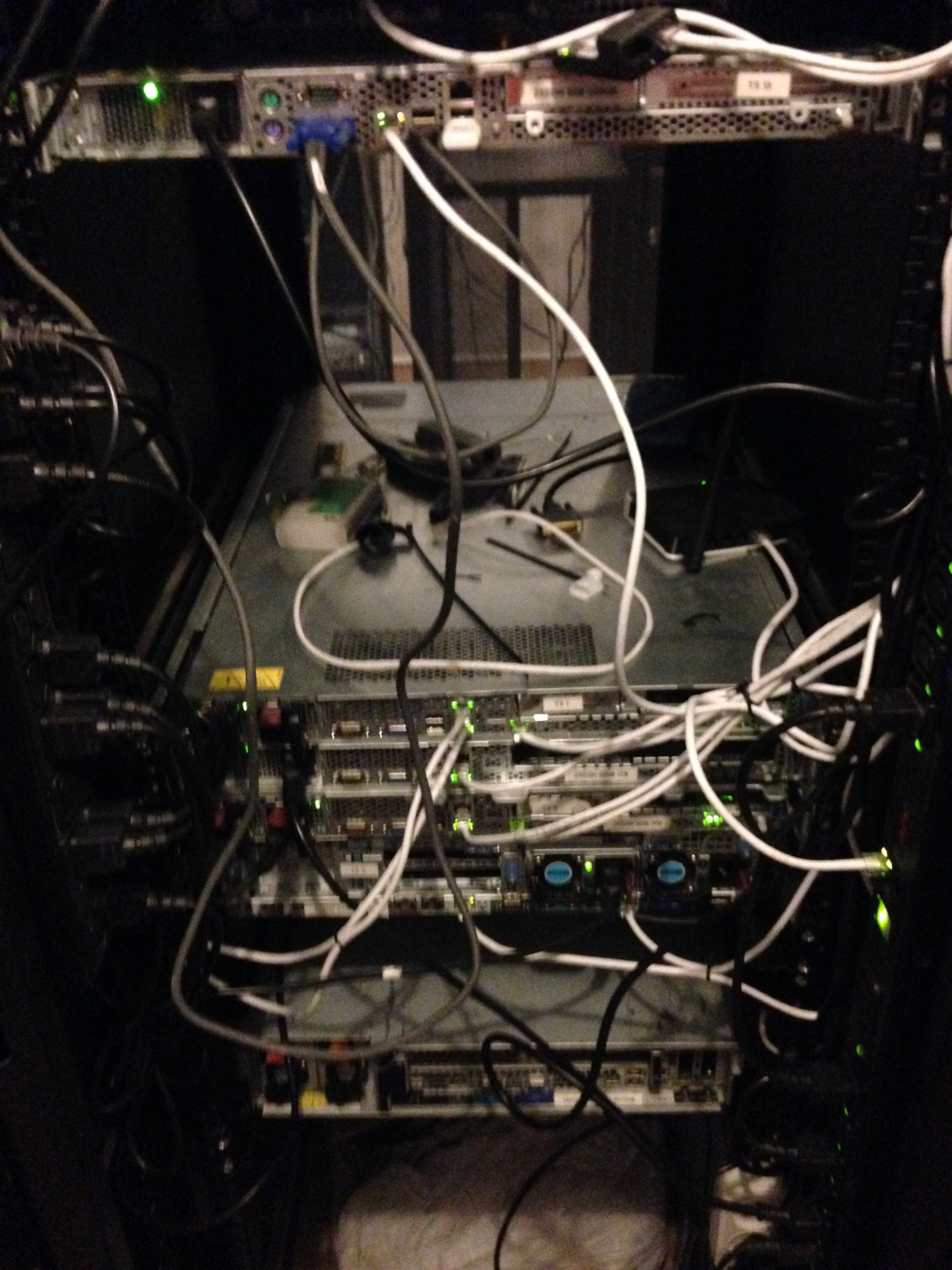

Примерно так мы работали еще около месяца, пока не заполнили оборудованием пол шкафа.

Так мы встречали вторую партию нашего оборудования, опять же HP (не реклама). Просто лучше иметь серверы которые взаимо-заменяемы, чем наоборот.

Исходя из того, что ни у кого из нас нет огромного опыта прокладки СКС (кроме администраторов, которые как обычно не там где нужно) — приходилось учиться всему на лету. Так у нас лежали провода первое время (около дня) когда мы устанавливали серверы.

Примерно так — стало уже после установки всего пришедшего оборудования и прокладки.

По мере роста компании мы все чаще сталкивались с определенными трудностями. Были и проблемы с оборудованием (отсутствие в быстром доступе кабелей SAS-SATA), его подключением, разными тонкостями и с DDoS атаками на нас (прилетали и такие что клали весь ЦОД). Но одна из главных, по нашему мнению — нестабильность ЦОДа в котором мы арендовали шкаф под оборудование. Мы и сами то были, не сильно стабильны, но когда падает и цод в котором ты размещаешься — это совсем плохо.

Исходя из того что ЦОД находился в старом полу-заброшенном здании производственного комплекса — работал он соответственно. И несмотря на то, что его владелец прикладывал все усилия чтобы он работал стабильно (а это истинная правда, Александр действительно молодец и во многом нам помог по началу) — отключали то свет, то интернет. Наверное это нас и спасло. Это стало причиной, которая побудила нас (без имеющихся на то финансов) приступить к поиску помещения для собственного дата-центра и организовать переезд в него менее чем за 14 дней (с учетом подготовки помещения, протяжки оптики и всего прочего) Но об этом, уже в следующей части нашего рассказа. О спешном переезде, поиске помещения и строительстве мини-цода в котором мы сейчас и обитаем.