Как сделать грабер для сайта

30 бесплатных программ для парсинга сайтов в 2020 году

Моя компания занимается парсингом сайтов в России уже более трёх лет, ежедневно мы парсим более 500 крупнейших интернет-магазинов в России. На выходе мы, как правило, отдаем данные в формате Excel/CSV. Но существуют и другие решения — готовые сервисы (конструкторы) для запуска парсинга практически без программирования. Ниже их список, краткая аннотация и рейтинг к каждому.

Парсинг сайтов — автоматизированный процесс извлечения данных или информации с веб-страниц. После извлечения необходимых данных по ним можно осуществлять поиск, переформатировать их, копировать и так далее.

Программное обеспечение для парсинга веб-страниц используется большинством компаний, занимаются они маркетингом, исследованиями или анализом данных. Парсинг полезен для сравнения продуктов и цен, поиска отзывов о товарах ваших конкурентов, поиска информации для размещения на вашем сайте или извлечения огромных объемов данных с веб-сайтов для проведения соответствующих маркетинговых исследований и так далее.

Ищете ли вы потенциальных клиентов, проводите анализ рынка или собираете данные для проверки своих моделей машинного обучения — вам так или иначе нужно получать данные со сторонних ресурсов. Вот некоторые из лучших бесплатных (или условно бесплатных) программ для парсинга веб-страниц с независимым рейтингом.

Mozenda помогает компаниям в сборе и организации данных наиболее экономичным и эффективным способом. Компания предлагает облачную архитектуру, которая обеспечивает масштабируемость, простоту использования и быстрое развертывание.

Внедрить Mozenda можно довольно быстро, к тому же развернуть это ПО можно за считанные минуты на уровне бизнес-подразделения без какого-либо участия ИТ-отдела. Его простой point-and-click интерфейс помогает пользователям создавать проекты и быстро экспортировать результаты, самостоятельно или по расписанию.

Благодаря простоте интеграции пользователи могут публиковать полученные результаты в формате CSV, TSV, XML или JSON.

Что говорят пользователи (упоминания в социальных сетях): «Мне понравилось, как быстро можно настроить программу и собрать данные с сайтов. Я мог бы начать новый проект, задать параметры и начать собирать данные за несколько часов. Данные почти всегда собираются в правильном формате, без каких-либо пробелов. Инструмент прост в использовании и ограничен только тарифным планом».

Компания Automation Anywhere состоит из группы экспертов, которые сосредоточены на предоставлении полностью понимаемых и гибких процессов создания ботов, предназначенных для автоматизации задач.

Такие боты не только просты в использовании, но и достаточно мощны, чтобы автоматизировать задачи любого уровня сложности. Это единственная роботизированная платформа, разработанная для современных предприятий, которая может создавать программных ботов для автоматизации задач от начала и до конца.

Что говорят пользователи: «Automation Anywhere — это отличная платформа, создающая ботов, которые выполняют все типы задач и рейтинг сокращающих ручной труд. Она предоставляет нам множество встроенных функций. Мне нравится больше всего валидация PDF-документов, с высокой точностью и большой скоростью. Это помогает мне увеличить производительность».

Предоставляя вам простые шаги и идиомы Python для навигации, Beautiful Soup дает доступ к инструментам извлечения любой необходимой информации. Программное обеспечение для парсинга веб-страниц автоматически преобразует входящие документы в Unicode и исходящие документы в UTF-8. Это позволяет вам использовать различные стратегии парсинга или изменять скорость и гибкость процессов.

Интерфейс Web Harvy позволяет легко выбрать элементы с нужной информацией. Извлеченные данные могут быть сохранены в файлы CSV, JSON, XML или в базе данных SQL.

В этом программном обеспечении имеется многоуровневая система парсинга категорий, которая может отслеживать ссылки на категории любых уровней и извлекать данные со страниц со списками. Инструмент предлагает вам большую гибкость и дает возможность использовать регулярные выражения.

Что говорят пользователи: «Мне нравится, как они сделали короткие обучающие видео. Это делает инструмент очень простым в использовании. Компания даже помогает использовать регулярные выражения для извлечения определенных текстов».

Простой интерфейс Content Grabber имеет прекрасную возможность автоматического обнаружения и настройки команд. Он мгновенно создает списки контента, обрабатывает нумерацию страниц и веб-форм, а также сам скачивает или закачивает файлы.

Content Grabber может извлекать контент с любого сайта, а затем сохранять его в виде структурированных данных в нужном вам формате, будь то таблицы Excel, XML, CSV или большинство из используемых сейчас баз данных. Его высокая производительность и стабильность обеспечивается оптимизированными браузерами, а также отлаженным процессом парсинга.

Примечание: компания также разрабатывает и продает Content Grabber Enterprise (CG Enterprise), который является премиальным продуктом для извлечения данных с сайтов, и он сегодня считаем самым современным инструментом на рынке.

Что говорят пользователи: «Прост в использовании, не требует специальных навыков программирования. Возможность получения данных с целевых сайтов за считанные минуты. Отлично подходит для создания списка потенциальных клиентов».

FMiner поддерживает как Windows, так и Mac, он имеет интуитивно понятный интерфейс и чрезвычайно прост в использовании. У этой программы мощный инструмент визуального дизайна, который фиксирует каждый ваш шаг и моделирует процесс сбора информации, когда вы взаимодействуете с целевыми страницами сайта.

FMiner позволяет собирать данные с различных веб-сайтов, включая онлайн-каталоги продукции, объявления о недвижимости и каталоги желтых страниц.

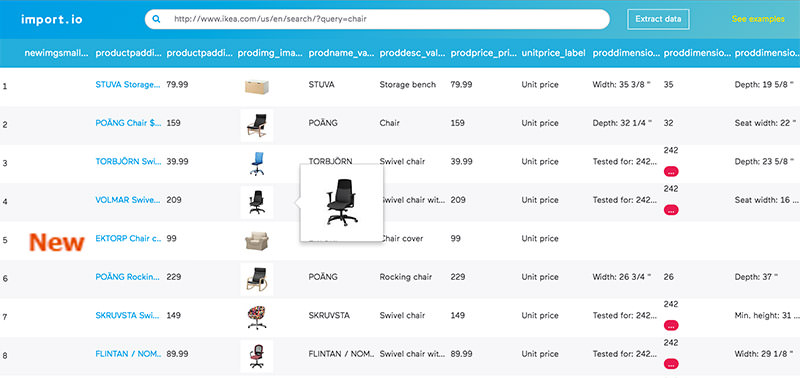

Import.io — признанный инструмент парсинга, который позволяет без проблем извлекать данные с сайтов. Все, что вам нужно сделать, это ввести URL-адрес, и система немедленно превратит страницы в данные.

Это программное обеспечение является идеальным решением для мониторинга цен, чтобы определить ожидания рынка и найти наиболее оптимальную цену. Он помогает вам генерировать качественные лиды и предоставляет ежедневные или ежемесячные обновления, чтобы помочь отслеживать действия конкурентов.

Что говорят пользователи: «С помощью интеллектуального извлечения данных легко начать работу, можно сделать многое и без регулярных выражений или настройки запросов — масштабируемость — отличная поддержка».

Visual Web Ripper — это продвинутый парсер для веб-страниц, который позволяет извлекать данные с динамических страниц, из каталогов продуктов, сайтов с объявлениями или финансовых сайтов.

После извлечения данных он помещает их в удобную и структурированную базу данных, электронную таблицу, файл CSV или XML. Поскольку он может обрабатывать сайты с поддержкой AJAX и многократно отправлять формы со всеми возможными значениями, он может работать там, где остальные парсеры пасуют.

Что говорят пользователи: «Visual Web Ripper сэкономил мое время, помог собрать нужную информацию со многих веб-сайтов. Если вы захотите получить информацию, Visual Web Ripper вас не подведет».

Webhose.io по запросу предоставляет вам доступ к структурированным веб-данным. Это позволяет создавать, запускать и масштабировать операции с большими данными независимо от того, являетесь ли вы исследователем, предпринимателем или руководителем компании.

Программное обеспечение структурирует, хранит и индексирует миллионы веб-страниц в день в разных вертикалях, таких как новости, блоги и онлайн-обсуждения.

Что говорят пользователи: «Сервис позволяет вам обращаться к множеству общедоступных данных, которые можно просто использовать для создания бизнес-инструментов».

Scrapinghub Platform известна тем, что создает, разворачивает и запускает веб-краулеры, обеспечивая получение новейшей информации. Данные можно легко просмотреть в красивом интерфейсе. Программное обеспечение также предоставляет вам платформу с открытым исходным кодом под названием Portia, которая предназначена для парсинга веб-сайтов.

Вы можете создавать шаблоны, нажимая на элементы на странице, а Portia обработает все остальное. Компания также создает автоматизированную утилиту, которая удаляет похожие страницы с веб-сайта.

Что говорят пользователи: «Четкий, подробный и прозрачный процесс. Удаленная и гибкая рабочая среда. Чрезвычайно дружелюбная обстановка для работы и прекрасный менеджмент».

Helium Scraper предлагает гибкий, интуитивно понятный интерфейс, который чрезвычайно прост. У этого инструмента широкий выбор настроек, так что вы можете выбрать те, которые необходимы вам. Вы можете просматривать сайты, извлекать и сохранять данные.

GNU Wget помогает получать данные с использованием HTTP, HTTPS и FTP, наиболее используемых интернет-протоколов. Он может легко извлекать большие файлы, а также выполнять зеркалирование целых веб- или FTP-сайтов. Программное обеспечение работает хорошо, даже если соединение медленное или нестабильное.

Web Scraper предлагает два варианта: расширение для Google Chrome и облачную платформу. Программное обеспечение создает карты сайтов и перемещается по ним для извлечения необходимых файлов, изображений, текстов и ссылок.

Оно может выполнять несколько операций парсинга и извлечения больших объемов данных одновременно, а также позволяет экспортировать очищенные данные, например в CSV.

IEPY поставляется с инструментом анализа текстов и веб-интерфейсом. Его главная ценность — извлечение информации с пониманием взаимоотношений внутри нее в большом масштабе.

Если речь идет об извлечении информации о потенциальных клиентах, ценах, конкурентах и поставщиках, то ваш выбор — ScrapingExpert. Этот инструмент помогает расширить знания о вашей целевой аудитории, доле рынка, ценовой политике и поставках сырья, предоставляя вам информацию, связанную с вашими конкурентами и их продуктами, а также с доступными дилерами.

Его уникальные функции включают поддержку на сайте, панель управления на одном экране, управление прокси и настройку учетных данных на нужных сайтах.

Благодаря мощной технологии парсинга веб-страниц, Ficstar позволяет вам делать более осмысленные шаги в области создания и реализации компетентных бизнес-стратегий.

Он помогает в сборе больших данных, достигая даже самых дальних уголков интернета. Помимо того, что Ficstar безопасен и надежен, он прекрасно интегрируется в любую базу данных, и собранные данные можно сохранять в любом формате.

QL2 помогает своим пользователям управлять бизнес-процессами, ценами и доходами. Используя свою технологию поиска в реальном времени, это программное обеспечение помогает компаниям ежедневно выполнять многочисленные запросы.

Оно предоставляет своим пользователям всесторонние и актуальные данные о текущем рынке и целевой аудитории. QL2 получает информацию с разных платформ и помогает вам выполнять более глубокие и интенсивные исследования.

Система парсинга веб-страниц Frontera состоит из инструмента обхода сайтов и примитивов распространения/масштабирования. Платформа заботится обо всей логике и политиках, которые необходимо соблюдать во время процесса парсинга.

Она хранит и задает приоритеты в извлеченных данных, чтобы решить, какую страницу посетить в следующий раз, и делает все это осмысленным образом.

Apify предлагает специальные функции, а именно RequestQueue и AutoscaledPool. Он позволяет начать с нескольких URL-адресов, а затем переходить по ссылкам на другие страницы и запускать задачи извлечения данных с максимальной производительностью.

Доступные форматы данных – JSON, JSONL, CSV, XML, XLSX или HTML с CSS. Он поддерживает любой тип сайтов и имеет встроенную поддержку Puppeteer.

Что говорят пользователи: «Я запустил все буквально в течение нескольких минут. Нет необходимости изучать новые языки программирования или навыки».

WebSundew, с его инструментами получения и очистки данных, позволяет пользователям извлекать информацию с сайтов быстрее. Программное обеспечение для сбора данных получает данные с веб-сайтов с чрезвычайно высокой точностью и скоростью.

Сотрудники компании помогут вам настроить агента для извлечения данных, который будет работать над парсингом страниц.

Grepsr помогает вам просто управлять процессом извлечения данных с веб-страниц. Компании могут использовать получаемую информацию для поиска потенциальных клиентов, мониторинга цен, исследований рынка или агрегации контента.

Это удобное программное обеспечение для поиска в интернете имеет такие функции, как неограниченная скорость сканирования, однократное извлечение, глубокий и поэтапный обход, API и пользовательские интеграции. Grepsr предоставляет компаниям удобные для заполнения онлайн-формы, чтобы помочь им уточнить свои требования к данным, а также позволяет планировать сканирование в календаре.

Что говорят пользователи: «Это как щелкать выключателем или отвечать на телефонные звонки — все работает надежно и точно».

BCL — это специальное программное обеспечение для сканирования веб-страниц, которое сокращает не только время, необходимое для сбора данных, но и общее время рабочих процессов.

Решения BCL для извлечения данных и обработки информационных потоков помогают упростить процесс парсинга для каждой организации, которая решит его использовать.

Connotate Cloud достаточно эффективен для извлечения данных с сайтов, использующих JavaScript и Ajax. Это программное обеспечение для поиска в Интернете легко внедрить, к тому же оно использует передовые алгоритмы машинного обучения. Connotate Cloud не зависит от языка, что означает, что он может извлекать данные на любых языках.

Connotate Cloud анализирует содержимое и выдает предупреждения в случае необходимости каких-либо изменений. Его point-and-click интерфейс обладает мощными возможностями обработки, которые могут нормализовать контент сразу на нескольких сайтах. Кроме того, это ПО помогает автоматически связывать контент с соответствующими метаданными.

Что говорят пользователи: «Connotate является гибким и интеллектуальным и позволяет моей команде еженедельно контролировать десятки тысяч веб-сайтов».

Будучи визуальным инструментом, Octoparse обладает point-and-click интерфейсом и позволяет легко выбирать данные, которые нужно получить с веб-сайта.

Программное обеспечение может управлять как статическими, так и динамическими сайтами с помощью AJAX, JavaScript, файлов cookie и так далее. Оно также предлагает расширенные облачные сервисы, позволяющие извлекать большие объемы данных. Извлеченные данные можно экспортировать в форматы TXT, CSV, HTML или XLSX.

Что говорят пользователи: «Он простой, дружелюбный, интуитивно понятный и имеет линейный процесс взаимодействия».

Scrapy позволяет пользователям эффективно извлекать данные с сайтов, обрабатывать их и хранить в любом формате или структурах, которые они предпочитают. Одной из его уникальных особенностей является то, что он построен на основе асинхронной сетевой структуры Twisted. Среди других интересных особенностей Scrapy — простота использования, подробная документация и активное сообщество.

Функции Parsehub для парсинга веб-страниц позволяют сканировать как один, так и сразу несколько веб-сайтов с поддержкой JavaScript, AJAX, файлов cookie, сеансов и редиректов.

Он может анализировать и получать данные с разных веб-сайтов и преобразовывать их в значимую информацию. Программное обеспечение использует технологию машинного обучения для распознавания наиболее сложных документов и создает выходной файл в формате JSON, CSV, Google Sheets или отдает данные через API.

Что говорят пользователи: «Извлекает информацию с большинства веб-страниц и не требует от вас глубоких знаний. Базовая функциональность проста в использовании, а расширенной можно научиться и она очень сильна».

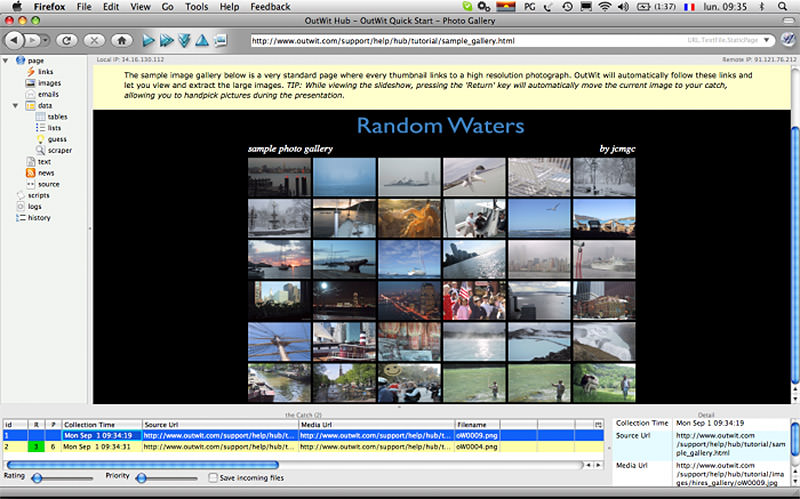

OutwitHub — лучший вариант, если вы хотите собирать данные, которые не всегда доступны. Он использует свои функции автоматизации для последовательного просмотра страниц, а затем выполняет задачи извлечения данных.

Информация может быть экспортирована в различных форматах, включая JSON, XLSX, SQL, HTML и CSV. OutWitHub можно использовать как в качестве расширения, так и в качестве отдельного приложения.

Ранее известный как CloudScrape, Dexi.io предоставляет различные типы роботов для выполнения операций в вебе — сканеры, экстракторы, автоботы и так далее.

Роботы-экстракторы являются наиболее продвинутыми, так как они позволяют вам выбрать любое действие, которое вы хотите, чтобы выполнил робот, например, нажатие кнопок или получение скриншотов. Программное обеспечение для поиска также предлагает несколько интеграций со сторонними сервисами.

Что говорят пользователи: «Я рад решению, которому легко научиться, а кроме того благодарен команде Dexi за помощь в настройке первой пары операций».

PySpider обладает распределенной архитектурой, которая поддерживает JavaScript-страницы и позволяет иметь сразу несколько сканеров. Он может хранить данные в выбранном вами бэкэнде, таком как MongoDB, MySQL, Redis и так далее.

RabbitMQ, Beanstalk и Redis могут использоваться в качестве очередей сообщений. Пользовательский интерфейс PySpider прост в использовании и позволяет редактировать сценарии, отслеживать текущие задачи и просматривать результаты.

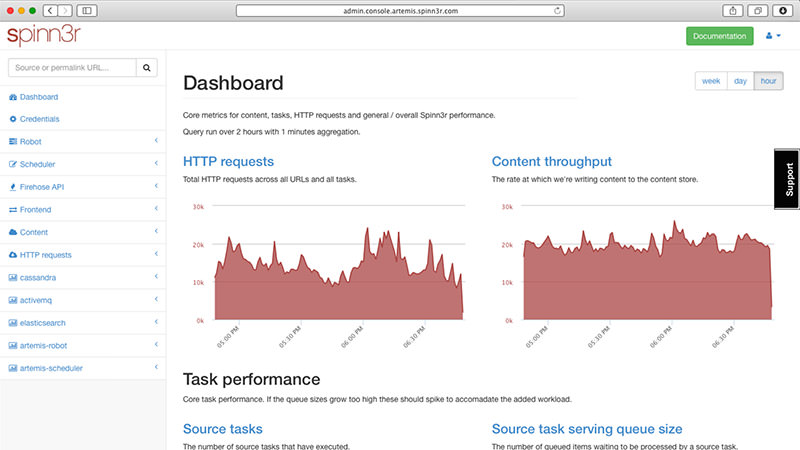

Если вы хотите собрать целую кучу данных из блогов, новостных сайтов, социальных сетей и RSS-каналов, Spinn3r станет отличным вариантом. Программное обеспечение использует Firehose API, который управляет 95% работ по сканированию и индексированию.

Вам предоставляется возможность фильтровать данные, которые он получает, по ключевым словам, что помогает отсеивать нерелевантный контент.

В наши дни парсинг стал неотъемлемой частью обработки данных. Компании и организации, как большие, так и малые, хотят сканировать сайты для сбора необходимых данных и принятия выгодных и эффективных решений на их основе. Это бесплатное программное обеспечение может помочь вам в этом процессе. Их уникальные функции и всеобъемлющий набор спецификаций дадут вам именно те инструменты для поиска в интернете, которые вы ищете.

10 инструментов, позволяющих парсить информацию с веб-сайтов, включая цены конкурентов + правовая оценка для России

Инструменты web scraping (парсинг) разработаны для извлечения, сбора любой открытой информации с веб-сайтов. Эти ресурсы нужны тогда, когда необходимо быстро получить и сохранить в структурированном виде любые данные из интернета. Парсинг сайтов – это новый метод ввода данных, который не требует повторного ввода или копипастинга.

Такого рода программное обеспечение ищет информацию под контролем пользователя или автоматически, выбирая новые или обновленные данные и сохраняя их в таком виде, чтобы у пользователя был к ним быстрый доступ. Например, используя парсинг можно собрать информацию о продуктах и их стоимости на сайте Amazon. Ниже рассмотрим варианты использования веб-инструментов извлечения данных и десятку лучших сервисов, которые помогут собрать информацию, без необходимости написания специальных программных кодов. Инструменты парсинга могут применяться с разными целями и в различных сценариях, рассмотрим наиболее распространенные случаи использования, которые могут вам пригодиться. И дадим правовую оценку парсинга в России.

1. Сбор данных для исследования рынка

Веб-сервисы извлечения данных помогут следить за ситуацией в том направлении, куда будет стремиться компания или отрасль в следующие шесть месяцев, обеспечивая мощный фундамент для исследования рынка. Программное обеспечение парсинга способно получать данные от множества провайдеров, специализирующихся на аналитике данных и у фирм по исследованию рынка, и затем сводить эту информацию в одно место для референции и анализа.

2. Извлечение контактной информации

Инструменты парсинга можно использовать, чтобы собирать и систематизировать такие данные, как почтовые адреса, контактную информацию с различных сайтов и социальных сетей. Это позволяет составлять удобные списки контактов и всей сопутствующей информации для бизнеса – данные о клиентах, поставщиках или производителях.

3. Решения по загрузке с StackOverflow

С инструментами парсинга сайтов можно создавать решения для оффлайнового использования и хранения, собрав данные с большого количества веб-ресурсов (включая StackOverflow). Таким образом можно избежать зависимости от активных интернет соединений, так как данные будут доступны независимо от того, есть ли возможность подключиться к интернету.

4. Поиск работы или сотрудников

Для работодателя, который активно ищет кандидатов для работы в своей компании, или для соискателя, который ищет определенную должность, инструменты парсинга тоже станут незаменимы: с их помощью можно настроить выборку данных на основе различных прилагаемых фильтров и эффективно получать информацию, без рутинного ручного поиска.

5. Отслеживание цен в разных магазинах

Такие сервисы будут полезны и для тех, кто активно пользуется услугами онлайн-шоппинга, отслеживает цены на продукты, ищет вещи в нескольких магазинах сразу.

В обзор ниже не попал Российский сервис парсинга сайтов и последующего мониторинга цен XMLDATAFEED (xmldatafeed.com), который разработан в Санкт-Петербурге и в основном ориентирован на сбор цен с последующим анализом. Основная задача — создать систему поддержки принятия решений по управлению ценообразованием на основе открытых данных конкурентов. Из любопытного стоит выделить публикация данные по парсингу в реальном времени 🙂

10 лучших веб-инструментов для сбора данных:

Попробуем рассмотреть 10 лучших доступных инструментов парсинга. Некоторые из них бесплатные, некоторые дают возможность бесплатного ознакомления в течение ограниченного времени, некоторые предлагают разные тарифные планы.

Import.io предлагает разработчику легко формировать собственные пакеты данных: нужно только импортировать информацию с определенной веб-страницы и экспортировать ее в CSV. Можно извлекать тысячи веб-страниц за считанные минуты, не написав ни строчки кода, и создавать тысячи API согласно вашим требованиям.

Для сбора огромных количеств нужной пользователю информации, сервис использует самые новые технологии, причем по низкой цене. Вместе с веб-инструментом доступны бесплатные приложения для Windows, Mac OS X и Linux для создания экстракторов данных и поисковых роботов, которые будут обеспечивать загрузку данных и синхронизацию с онлайновой учетной записью.

Webhose.io обеспечивает прямой доступ в реальном времени к структурированным данным, полученным в результате парсинга тысяч онлайн источников. Этот парсер способен собирать веб-данные на более чем 240 языках и сохранять результаты в различных форматах, включая XML, JSON и RSS.

Webhose.io – это веб-приложение для браузера, использующее собственную технологию парсинга данных, которая позволяет обрабатывать огромные объемы информации из многочисленных источников с единственным API. Webhose предлагает бесплатный тарифный план за обработку 1000 запросов в месяц и 50 долларов за премиальный план, покрывающий 5000 запросов в месяц.

3. Dexi.io (ранее CloudScrape)

CloudScrape способен парсить информацию с любого веб-сайта и не требует загрузки дополнительных приложений, как и Webhose. Редактор самостоятельно устанавливает своих поисковых роботов и извлекает данные в режиме реального времени. Пользователь может сохранить собранные данные в облаке, например, Google Drive и Box.net, или экспортировать данные в форматах CSV или JSON.

CloudScrape также обеспечивает анонимный доступ к данным, предлагая ряд прокси-серверов, которые помогают скрыть идентификационные данные пользователя. CloudScrape хранит данные на своих серверах в течение 2 недель, затем их архивирует. Сервис предлагает 20 часов работы бесплатно, после чего он будет стоить 29 долларов в месяц.

Scrapinghub – это облачный инструмент парсинга данных, который помогает выбирать и собирать необходимые данные для любых целей. Scrapinghub использует Crawlera, умный прокси-ротатор, оснащенный механизмами, способными обходить защиты от ботов. Сервис способен справляться с огромными по объему информации и защищенными от роботов сайтами.

Scrapinghub преобразовывает веб-страницы в организованный контент. Команда специалистов обеспечивает индивидуальный подход к клиентам и обещает разработать решение для любого уникального случая. Базовый бесплатный пакет дает доступ к одному поисковому роботу (обработка до 1 Гб данных, далее — 9$ в месяц), премиальный пакет дает четырех параллельных поисковых ботов.

ParseHub может парсить один или много сайтов с поддержкой JavaScript, AJAX, сеансов, cookie и редиректов. Приложение использует технологию самообучения и способно распознать самые сложные документы в сети, затем генерирует выходной файл в том формате, который нужен пользователю.

ParseHub существует отдельно от веб-приложения в качестве программы рабочего стола для Windows, Mac OS X и Linux. Программа дает бесплатно пять пробных поисковых проектов. Тарифный план Премиум за 89 долларов предполагает 20 проектов и обработку 10 тысяч веб-страниц за проект.

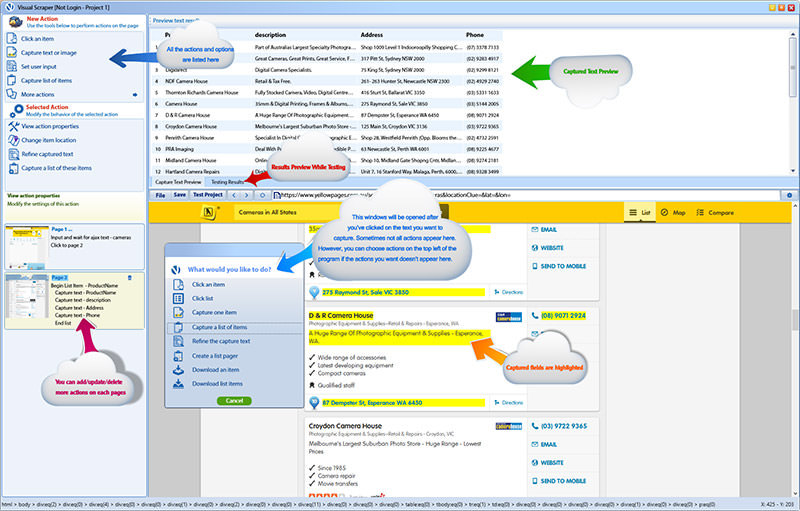

VisualScraper – это еще одно ПО для парсинга больших объемов информации из сети. VisualScraper извлекает данные с нескольких веб-страниц и синтезирует результаты в режиме реального времени. Кроме того, данные можно экспортировать в форматы CSV, XML, JSON и SQL.

Пользоваться и управлять веб-данными помогает простой интерфейс типа point and click. VisualScraper предлагает пакет с обработкой более 100 тысяч страниц с минимальной стоимостью 49 долларов в месяц. Есть бесплатное приложение, похожее на Parsehub, доступное для Windows с возможностью использования дополнительных платных функций.

Spinn3r позволяет парсить данные из блогов, новостных лент, новостных каналов RSS и Atom, социальных сетей. Spinn3r имеет «обновляемый» API, который делает 95 процентов работы по индексации. Это предполагает усовершенствованную защиту от спама и повышенный уровень безопасности данных.

Spinn3r индексирует контент, как Google, и сохраняет извлеченные данные в файлах формата JSON. Инструмент постоянно сканирует сеть и находит обновления нужной информации из множества источников, пользователь всегда имеет обновляемую в реальном времени информацию. Консоль администрирования позволяет управлять процессом исследования; имеется полнотекстовый поиск.

80legs – это мощный и гибкий веб-инструмент парсинга сайтов, который можно очень точно подстроить под потребности пользователя. Сервис справляется с поразительно огромными объемами данных и имеет функцию немедленного извлечения. Клиентами 80legs являются такие гиганты как MailChimp и PayPal.

Опция «Datafiniti» позволяет находить данные сверх-быстро. Благодаря ней, 80legs обеспечивает высокоэффективную поисковую сеть, которая выбирает необходимые данные за считанные секунды. Сервис предлагает бесплатный пакет – 10 тысяч ссылок за сессию, который можно обновить до пакета INTRO за 29 долларов в месяц – 100 тысяч URL за сессию.

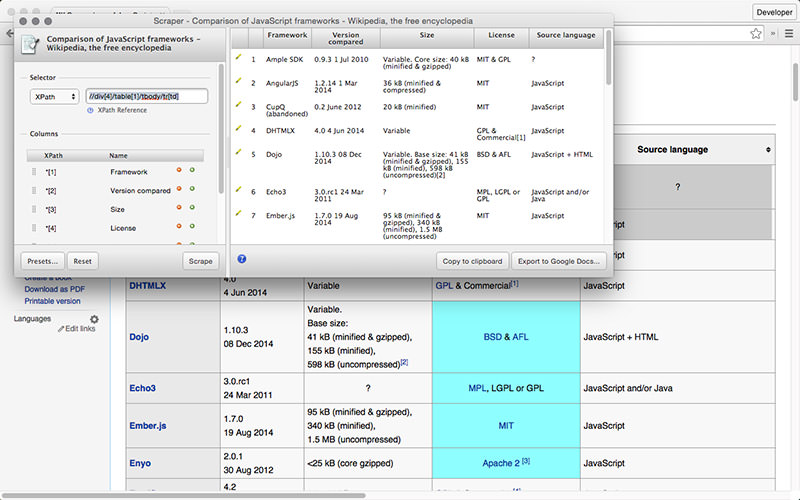

Scraper – это расширение для Chrome с ограниченными функциями парсинга данных, но оно полезно для онлайновых исследований и экспортирования данных в Google Spreadsheets. Этот инструмент предназначен и для новичков, и для экспертов, которые могут легко скопировать данные в буфер обмена или хранилище в виде электронных таблиц, используя OAuth.

Scraper – бесплатный инструмент, который работает прямо в браузере и автоматически генерирует XPaths для определения URL, которые нужно проверить. Сервис достаточно прост, в нем нет полной автоматизации или поисковых ботов, как у Import или Webhose, но это можно рассматривать как преимущество для новичков, поскольку его не придется долго настраивать, чтобы получить нужный результат.

OutWit Hub – это дополнение Firefox с десятками функций извлечения данных. Этот инструмент может автоматически просматривать страницы и хранить извлеченную информацию в подходящем для пользователя формате. OutWit Hub предлагает простой интерфейс для извлечения малых или больших объемов данных по необходимости.

OutWit позволяет «вытягивать» любые веб-страницы прямо из браузера и даже создавать в панели настроек автоматические агенты для извлечения данных и сохранения их в нужном формате. Это один из самых простых бесплатных веб-инструментов по сбору данных, не требующих специальных знаний в написании кодов.

Самое главное — правомерность парсинга?!

Вправе ли организация осуществлять автоматизированный сбор информации, размещенной в открытом доступе на сайтах в сети интернете (парсинг)?

В соответствии с действующим в Российской Федерации законодательством разрешено всё, что не запрещено законодательством. Парсинг является законным, в том случае, если при его осуществлении не происходит нарушений установленных законодательством запретов. Таким образом, при автоматизированном сборе информации необходимо соблюдать действующее законодательство. Законодательством Российской Федерации установлены следующие ограничения, имеющие отношение к сети интернет:

1. Не допускается нарушение Авторских и смежных прав.

2. Не допускается неправомерный доступ к охраняемой законом компьютерной информации.

3. Не допускается сбор сведений, составляющих коммерческую тайну, незаконным способом.

4. Не допускается заведомо недобросовестное осуществление гражданских прав (злоупотребление правом).

5. Не допускается использование гражданских прав в целях ограничения конкуренции.

Из вышеуказанных запретов следует, что организация вправе осуществлять автоматизированный сбор информации, размещенной в открытом доступе на сайтах в сети интернет если соблюдаются следующие условия:

1. Информация находится в открытом доступе и не защищается законодательством об авторских и смежных правах.

2. Автоматизированный сбор осуществляется законными способами.

3. Автоматизированный сбор информации не приводит к нарушению в работе сайтов в сети интернет.

4. Автоматизированный сбор информации не приводит к ограничению конкуренции.

При соблюдении установленных ограничений Парсинг является законным.

p.s. по правовому вопросу мы подготовили отдельную статью, где рассматривается Российский и зарубежный опыт.

Какой инструмент для извлечения данных Вам нравится больше всего? Какого рода данные вы хотели бы собрать? Расскажите в комментариях о своем опыте парсинга и свое видение процесса…